Strony wątpliwej jakości mogą nie tylko nie zajmować wysokich pozycji w rankingu, ale nawet nie znajdować się w indeksie. Między teorią a praktyką jest jednak przepaść. Ostatnie tygodnie pokazują, że Google ma znacznie poważniejszy problem z nasileniem spamerskich stron, niż kiedykolwiek sądziliśmy. Niewątpliwą pomocą dla spamerów jest powstanie nowoczesnych modeli językowych A.I., z których treścią Google nawet nie zaczął sobie radzić. W tym artykule analizujemy ostatnie problemy związane ze spamem w rankingu Google i zastanawiamy się, co można z tym zrobić!

Google walczy ze spamem… bądź nie

Google w wielu miejscach oficjalnej dokumentacji, m.in. Google Central Guidance (wcześniej: Webmaster Guidance) oraz Google Blog, podkreśla znaczenie walki ze spamem w wynikach wyszukiwania. Zdolność do zwalczania spamu jest fundamentalna w celu utrzymania jakości wyników wyszukiwania, która w przeciwnym razie szybko zostałaby obniżona. Strony spamerskie utrudniają znalezienie wartościowych informacji, wydłużają proces sprawdzania wyników wyszukiwania, co przekłada się na mniejsze zadowolenie użytkowników. Spam bezpośrednio atakuje także fundamenty algorytmów wyszukiwania, a jego rozwój sprawia, że właściciele stron działających zgodnie z zasadami, ale na skutek działań spamerów otrzymujące niższe wyniki w rankingu, mogą słusznie czuć się poszkodowani. Na pierwszy rzut oka wszystko więc wskazuje na to, że Google ma wszelkie argumenty, aby skutecznie zwalczać spamerskie strony. Czy jednak tak się dzieje? Niezupełnie.

Jak definiujemy spamerskie strony w Google?

Na początku warto zdefiniować, czym jest spam w wynikach wyszukiwania i jak rozumiemy stronę spamerską w Google Search. Oficjalnie Google stosuje różne algorytmy i metody, aby identyfikować oraz penalizować spamerskie strony. Identyfikacja strony jako spam może wiązać się z ostrzeżeniem, czasową blokadą, a nawet trwałym wykluczeniem z indeksu Google Search.

Strony spamerskie w Google definiujemy jako witryny internetowe, które stosują nieakceptowane praktyki do poprawienia pozycji w wynikach wyszukiwania Google Search. Wykorzystywane działania często naruszają zasady etyczne optymalizacji dla wyszukiwarek lub znajdują się w tzw. szarej strefie. Obecnie najpopularniejsze techniki dotyczą wykorzystywania akceptowanych metod pozycjonowania stron w sposób, który daje odmienne rezultaty. Przykładem może być tworzenie treści – content jest uznawany przez Google za jeden z najistotniejszych papierków lakmusowych badających jakość strony. Nadmierne stosowanie słów kluczowych, tworzenie opasłej treści, encyklopedii i innych form contentu może mijać się z jakością i użytecznością, wciąż jednak wpływać pozytywnie na proces pozycjonowania.

Ze względu na akceptację danych działań przez regulaminy wyszukiwarek strony spamerskie mogą powstawać z wykorzystaniem dwóch rodzajów działań:

- działania black hat i grey hat – różnego rodzaju działania, które pośrednio bądź bezpośrednio łamią regulamin wyszukiwarki, np. tworzenie nakładek ze słowami kluczowymi, wykorzystywanie skopiowanego contentu i nie tylko.

- działania kamuflażowe – strony używają legalnych technik sensu stricto, ale w taki sposób, który nie zapewnia pożądanych przez wyszukiwarki rezultatów, np. wysokiej jakości treści. Skuteczność takich metod wynika przede wszystkim z nieskuteczności identyfikowania ich z poziomu algorytmów Google.

Walka ze spamem to niekończąca się batalia, która polega przede wszystkim na dostosowaniu mechanizmów weryfikacji środków używanych przez właścicieli stron do skutecznej identyfikacji działań niepożądanych. Niezależnie cały czas powstają jednak także nowe działania spamerskie i nowe techniki.

O ile Google odniosło pewne sukcesy w zakresie walki z działaniami pierwszej kategorii, czego przykładem mogą być aktualizacje z początku drugiej dekady XXI w., o tyle wciąż ma ogromny problem z identyfikacją bardziej inteligentnych sposobów obchodzenia zasad. Sytuacja znacznie pogorszyła się na skutek rozwoju inteligentnych modeli językowych A.I., do czego wrócimy jeszcze poniżej.

Po czym rozpoznać SPAM w Google Search?

Kiedyś strony spamerskie w Google rozpoznawaliśmy po specyficznych informacjach Search Snippet. Nieskładne meta description, niepasujące tytuły stron do adresów URL to główne znaki rozpoznawcze. Dzisiaj takie sytuacje są znacznie rzadsze i najczęściej związane są z masowymi atakami na strony internetowe, czego najlepszym przykładem może być głośny ostatnio Japanese Keyword Hack, który sieje chaos na stronach z CMS WordPress.

Najczęściej strony spamerskie zbudowane są w celu zbierania ruchu organicznego do dalszego wykorzystywania w obrębie zbierania danych i informacji o użytkownikach, przekierowaniach (również do niebezpiecznych stron wykorzystujących phishing) i przekonwertowywania mocy na pozostałe strony. Charakterystyka tego typu witryn jest jednak podobna, dzięki czemu łatwo je rozpoznać (a przynajmniej łatwiej, niż algorytmom Google).

Główne cechy stron spamerskich to:

- niska jakość treści – strony zawierają powtarzalne, nieoryginalne i nieciekawe treści, takie jak kopie zawartości innych stron i treści generowane automatycznie przez modele językowe A.I. Zgodnie z powiedzeniem Danny’ego Sullivana z Google, to treści, które każdy łatwo lubi dzisiaj produkować, ale nikt nie chce ich czytać. Wartości użytkowe są bardzo niskie, choć nie zawsze w oczach algorytmów wyszukiwania.

- nadużywanie słów kluczowych – po aktualizacji Pingwin techniki black hat radykalnie się zmniejszyły, ale wciąż istnieją. Nadużywanie słów kluczowych to charakterystyczna praktyka witryn spamerskich. Wprowadzanie nadmiernych ilości słów kluczowych w treści strony w nadziei na manipulację wynikami wyszukiwania jest praktyką niezgodną z zasadami Google. Nie oznacza to jednak, że jest to praktyka zupełnie nieskuteczna.

- niskiej jakości profil linków – strony spamerskie najczęściej mają bardzo dużą ilość linków zwrotnych, ale są to odnośniki bardzo niskiej jakości, często w ogóle bez autorytetu. Wciąż aktualne są schematy piramid i inne techniki budowania zaplecza linkowego z wielu źródeł.

- częste przekierowania – Używanie przekierowań w celu przekierowania użytkowników na inne strony jest częstą praktyką, którą identyfikujemy w obrębie stron spamerskich. Przekierowania mogą prowadzić zarówno do zagrożeń cyfrowych, jak i w celach marketingowych.

- agresywna polityka reklamowa – na stronach spamerskich często znajduje się wiele narzucających się reklam, wstawek pop-up i innych elementów, które przysłaniają treść i zawierają odnośniki do innych stron.

- cloaking – tworzenie warstwy na stronie w celach optymalizacyjnych, która ukrywa prawdziwy cel strony przed botami Google. Powszechnie stosowana praktyka w złotej erze black hat SEO.

- phishing – strony spamerskie mogą też być nastawione bezpośrednio na działania szkodliwe dla użytkowników. Witryny wykorzystujące mechanizmy phishingowe próbują wyłudzić poufne dane od użytkowników, m.in. dane finansowe.

Google naprawdę nie radzi sobie ze spamem

Praktyki SEO zmieniają się w czasie, a głównym czynnikiem, który na to wpływa, jest polityka Google i skuteczność jej wdrażania. Wytyczne są jasne: Google premiuje strony, które są wartościowe dla innych użytkowników, które są merytorycznie poprawne i bezpieczne, a także mają wartościową treść. Problem polega jednak w skuteczności metod odpowiadających za przełożenie wymagań teoretycznych na implementację praktyczną.

Przykładowo, pierwszy z powyższych czynników realizowane jest m.in. poprzez szereg pomniejszych kryteriów. To, czy Google uzna stronę za wartościową dla użytkownika, przynajmniej na płaszczyźnie teorii, bo dokładnych list rankingowych nie znamy, wpływa analiza wyświetleń, ruch na stronie, social media, zaangażowanie użytkowników itd. Wydaje się jednak, że wciąż kluczowym elementem jest linkowanie, a w obrębie off-site SEO mechanizmy kontroli jakości Google wydają się często zupełnie archiwalne.

To samo dotyczy sposobu weryfikowania jakości treści. Co z tego, że mamy nowe mapy wiedzy (N-E-E-A-T-T), skoro Google nie ma efektywnych środków ich implementacji i weryfikacji. W oficjalnej dokumentacji Google nie brakuje tych samych postulatów, które specjaliści branży SEO widzieli wiele lat wcześniej. Gigant zaleca, aby dbać o wysoką jakość treści na stronie, stosować zasady etyczne optymalizacji dla wyszukiwarek i unikać praktyk, które mogą zostać uznane za spamerskie. Jednak w jaki sposób powyższe koresponduje z faktem, że na w pierwszych kilkudziesięciu wynikach wyszukiwania coraz częściej możemy znaleźć strony, które w żadnym stopniu nie reprezentują wartości promowanych przez Google? I ostatecznie: czy nie jest tak, że zjawisko spamu w wynikach wyszukiwania jest korzystne dla Google, bo skuteczniej może oferować alternatywę w postaci Google Ads?

Case study. Zmasowany atak spamerskich stron w Google (grudzień 2023 / styczeń 2024)

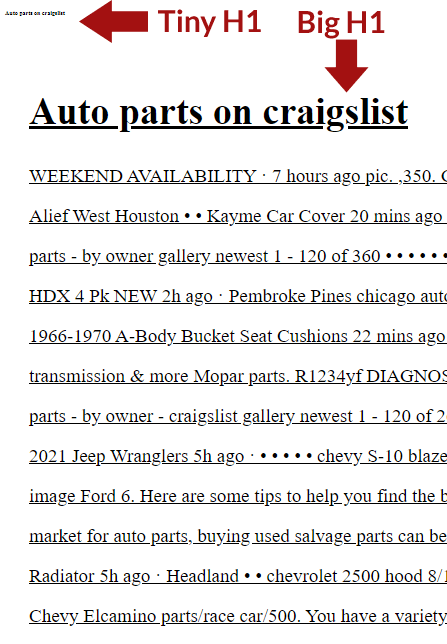

Ciekawy eksperyment przeprowadziła ostatnio Lily May, która podzieliła się rezultatami na platformie X 20 grudnia 2023 r. Historię opisał m.in. The Hoth. Wyszukując frazę Craiglist used motor parts w wyszukiwarce, odkryto, że każdy wynik w pierwszej dwudziestce pochodził z witryn spamerskich. Wbrew pozorom nie były to jednak jakoś sprytnie zakamuflowane witryny. Były to zwykłe strony “śmieciowe”, które nie powinny mieć żadnego prawa do zajmowania pozycji w wynikach wyszukiwania.

Społeczność zaczęła analizować temat i szybko okazało się, że wcale nie było to jednostkowe zdarzenie. Okazało się, że Google padło ofiarą masowego ataku spamu utrzymującego się przez około tydzień. Chociaż w momencie pisania niniejszego artykułu sytuacja nieco się polepszyła, wciąż jest gorzej niż przed grudniem.

Walka ze spamem nie zna końca, a jej początek przypada właściwie na samo powstanie wyszukiwarek internetowych. Ale dostrzeżenie z grudnia pozwoliło dokładniej przyjrzeć się problemowi. Na jaw wyszło, że niektóre domeny zajmują czołowe pozycje dla setek tysięcy słów kluczowych, a wiele z nich zostało zarejestrowanych w ciągu ostatnich 24–48 godzin przed atakiem. Są to jasne dowody nieczystych działań, które nie powinny pozwolić tym witrynom spamerskim dominować w wynikach SERP.

Trudno stwierdzić, co jest bardziej bulwersujące: fakt, że tego typu strony znalazły się w ogóle w rankingu wyszukiwarki (wiele z nich nie powinno zostać zaindeksowanych zgodnie z polityką Google), czy to, że część z nich zajmowało wysokie pozycje na nawet przeszło 300 000 słów kluczowych. I – co istotne – nie mówimy tutaj o gigantach; stronach budowanych przez lata, lecz prostych stronach opartych głównie o znanego nam dobrze WordPressa…

Atak spamerski w Google Search. Reakcja Google

Reakcja Google pozostawia wiele do życzenia. Od dawna firma zaleca ignorowanie linków spamerskich, jeśli chodzi o profil linków strony. Nie trzeba nic z nimi robić – Google wie, jak się nimi zająć, jak przeprowadzić neutralizację profilu, przynajmniej rzekomo i od czasu wdrożenia Pingwina 4.0. Tego typu linki nie powinny stanowić ani wartości ujemnej, ani wartości dodanej.

Użytkownicy masowo zaczęli zgłaszać toksyczne linki prowadzące do ich stron. Nie są to sytuacje wyodrębnione. Jeden z użytkowników zapytał Johna Muellera o zastosowanie komendy disavov. Wskazał, że limit dla tej komendy wynosi 100 000 adresów. Tymczasem spam miał znacznie większą objętość. Odpowiedź pozostawia wiele do życzenia: zdaniem Muellera wystarczy zignorować te linki.

Spamerzy tworzą miliony stron z długimi frazami, które mogą w krótkim czasie zajmować pozycje dla setek tysięcy słów kluczowych każdego dnia. Wykorzystują też luki w algorytmach wyszukiwania lokalnego, które pozwalają na manipulowanie wyświetlanymi rezultatami.

Jak rozwój modeli językowych A.I. przyczynił się do obniżenia jakości wyników wyszukiwania?

Rozwój modeli językowych sztucznej inteligencji wpływa na obniżenie jakości wyników wyszukiwania w kilku znaczeniach. Po pierwsze, zaawansowane modele językowe A.I. są zdolne do generowania automatycznych treści, lecz nie zawsze dostarczają rzetelnych informacji, co prowadzi do powstawania fałszywych lub wprowadzających w błąd treści. Poziom tekstu zależy w dużej mierze od komend użytkownika, a tych często brakuje. Treści mogą co prawda powstawać lawinowo, ale nikt nie chce ich czytać, bo są pisane “na jedno kopyto”.

Ryzyko manipulacji treścią w celu uzyskania lepszej widoczności w wynikach wyszukiwania stało się realne i póki co Google nie ma decydującego głosu w tej sprawie. Jak pokazują przytoczone wydarzenia z ostatnich tygodni, brakuje po prostu skutecznych narzędzi weryfikacji jakości treści.

Rozwój modeli językowych sprzyja również rozprzestrzenianiu niebezpiecznych informacji, co ułatwia tworzenie stron spamerskich, phishingowych, nastawionych na wyciąganie danych użytkowników. W dużym stopniu będzie to kształtować środowisko wyników wyszukiwania i pogarszać jakość rezultatów. Dopóki jednak nie powstaną skuteczne mechanizmy weryfikacji linków i jakości treści, dopóty, prawdopodobnie coraz szybciej, rozwijać się będą strony spamerskie.

Nasilenie spamu niszczy Google Search. Podsumowanie

Problemy z analizą linków wróciły po latach ze zdwojoną siłą, a Google wydaje się nie mieć wystarczających środków do rzetelnej weryfikacji stron. Zezwolenie na indeksowanie tak oczywistych stron spamerskich oznacza dalszy wzrost problemów dla uczciwych właścicieli stron. Z pewnością Google bardziej zdaje sobie sprawę z zagrożenia, jakie to ze sobą niesie, ale nie jest jasne, czy posiada odpowiednie narzędzia do jego wyeliminowania.

Przez ostatnie lata w dużym stopniu polityka Google zorientowana była na promowania tworzenia wartościowego contentu. Wprowadzenie na rynek publicznie dostępnych modeli językowych A.I., takich jak Chat GPY od Open A.I., zrewidowało ostatecznie zapowiedzi giganta. Długa droga jeszcze do efektywnej weryfikacji treści, bo obecnie algorytmy Google mają nie tylko trudność w identyfikacji contentu A.I., ale także w identyfikacji niepoprawnie wygenerowanych zbitek tekstów i linków stron spamerskich o zerowej reputacji. Pod tym względem nie widać na ten moment światełka w tunelu. Na pewno u progu 2024 roku pozycjonowanie stron w Google, przynajmniej uczciwe, będzie bardziej wymagające.