Funkcje snippetów miały ułatwić użytkownikom korzystanie z wyszukiwarki. Kolejne dodatki, od karuzel po wyniki z wielu źródeł, unaoczniają prawie przestępcze procedery związane z wybieraniem wyników, które znajdą się w elementach rozszerzonych. Chociaż Google potępia działania niezwiązane z jakością, okazuje się, że firma sama stosuje tzw. programatyczne SEO. W tym artykule przyglądamy się ewolucji Google w tym zakresie, konsekwencjom wprowadzania kolejnych zmian i kontrowersjom etycznym. W tle duże pieniądze i proces antymonopolowy w UE. Zachęcamy do czytania!

Kolejne kontrowersje wokół Google

Pokłosie ostatnich wpadek Google związanych z wciąż przegraną walką ze stronami spamerskimi czy błędami w Google Ads rozszerza się na inne elementy. Po artykule How Google is killing independent sites like ours zrobiło się głośno o kwestii uczciwości Google, a także dokładności algorytmów i przejrzystości wyników wyszukiwania. Obawy dotyczą przede wszystkim niejasnych zasad promowania dużych marek – nie w Google Ads, a w wynikach wyszukiwania. Oficjalnie Google nie przyznaje się do takich działań.

W tym artykule przyjrzymy się, w jaki sposób te czynniki zderzają się na przykładzie snippetów. Analiza na łamach Search Engine Journal udowadnia, że poszczególne funkcje Google w SERP mają na celu ewidentnie dostarczyć gigantowi większych zysków, jednocześnie sprzeciwiając się opracowywanym wytycznym dotyczącym treści i normom etycznym.

Od karuzeli, przez listy, na różnych źródłach z sieci skończywszy. Jak Google samo się pogubiło?

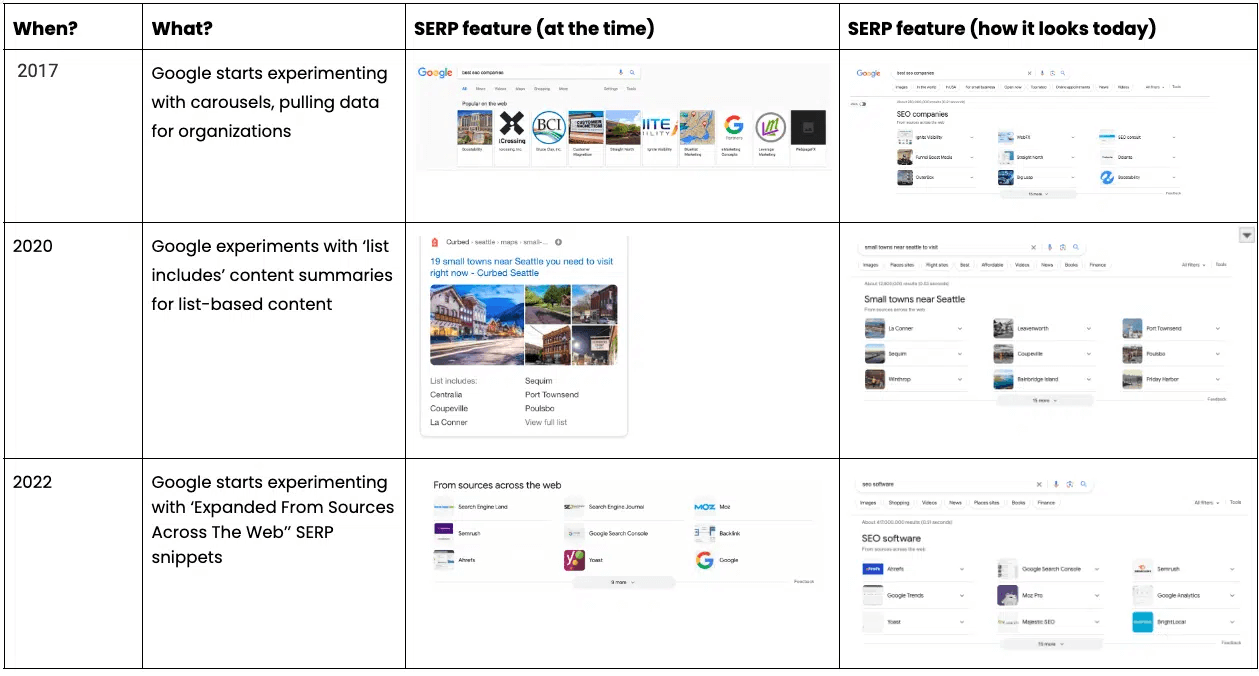

Aby zrozumieć nieprawidłowości, do których Google ma się dopuszczać regularnie, trzeba zacząć od przypomnienia zmian, jakie zaszły w wyszukiwarce po 2017 roku. To właśnie wtedy Google zaczęło eksperymentować z “karuzelami”, czyli najprościej mówiąc sliderami, które wyskakują na samej górze wyników wyszukiwania. Na początku karuzele dotyczyły tylko rynku amerykańskiego, ale w przeciągu trzech kolejnych lat Google szybko zaczęła je implementować także na innych rynkach. Zmieniały się także tematyki wyszukiwania, w jakich można spotkać slidery. Początkowo była to odpowiedź wyłącznie na prompt o charakterze czysto zakupowym, np. “ubranka dla dzieci”. Prędko bazowy zakres został rozszerzony o funkcje przeglądowe. Dla przykładu: wyszukując jakiś film, jest bardzo prawdopodobne, że Google w formie karuzeli zaproponuje podobne seanse.

W 2020 roku Google wprowadza streszczenia dla treści opartych na listach. To przełomowy moment, bo strony na wysokich pozycjach w wynikach wyszukiwania zyskują większą rozpoznawalność (wprowadzenie list “fizycznie” zajmuje więcej miejsca w SERP z poziomu użytkownika). Dwa lata później, w 2022 roku, Google zaczęło wprowadzać funkcję SERP z różnych źródeł, która obecnie wydaje się zastępować wszystkie wcześniejsze funkcje streszczeń treści opartych na listach.

Funkcje “z różnych źródeł w sieci” to obecnie rozszerzenie stosowane głównie dla promptów o charakterze komercyjnym. Obejmuje ono takie zapytania, jak:

- Najlepsze miejsce / usługi / oprogramowanie,

- Lista kontrolna (np. Youtube),

- Software (ERP, SEO, AI),

- Pomysły (np. na obiad, na randkę, na kreatywne spędzenie czasu),

- Narzędzia (np. narzędzia analityczne, narzędzia SaaS, narzędzia SEO).

W tym wszystkim jednak Google zaczęło się ewidentnie gubić. Dodatkowe funkcje nie tylko nie spełniły podstawowego celu, jakim jest poprawa doświadczeń użytkowników, wygody procesu wyszukiwania itd. O ile karuzele mogły być uznane i za przydatne, i wizualnie atrakcyjne dla użytkownika, o tyle kolejne rozwiązania były oceniane jako coraz bardziej problematyczne. Z perspektywy branży SEO podkreśla się także, że ostatnie zmiany skutecznie zmniejszają widoczność rzetelnych wyników, pogarszając tym samym jakość SERP oraz utrudniając mniejszym wydawcom walkę o pierwsze miejsca w wynikach.

Programatyczne SEO, czyli co wolno wojewodzie, to nie Tobie… SEOwcu

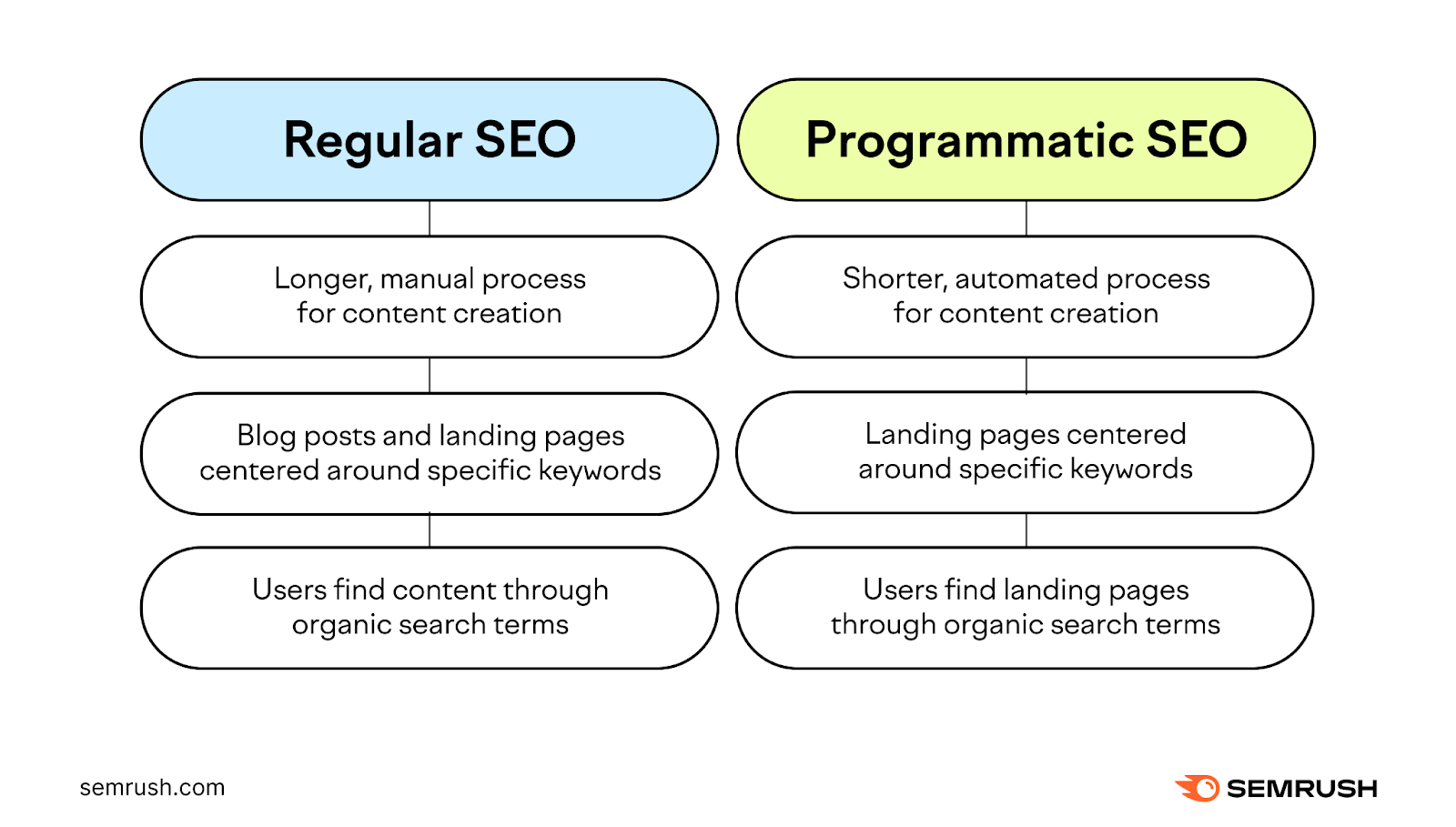

Google od dawna przestrzega przed stosowaniem tzw. programatycznego SEO (programmatic SEO). Obecnie często ten termin kojarzy się z contentem generowanym przez duże modele językowe. Tego typu działania też mogą się zaliczać do tej kategorii, ale bynajmniej nie tylko one. Na czym polega programmatic SEO?

Programatyczne SEO to zespół działań ukierunkowanych na automatyzację procesu tworzenia treści i wykorzystanie treści jako narzędzia pozycjonowania, a nie przekazywania wiedzy. Próbując sobie wyobrazić najbardziej przejaskrawioną egzemplifikację takich działań, na myśl przychodzi stworzony bez ładu i składu spam, który został zoptymalizowany poprzez nasycenie różnych keywordsami i powstaje automatycznie albo powtarzalnie. Treści tego typu są krótsze, mniej bądź wcale nieoryginalne, a użytkownicy trafiają do nich głównie poprzez strony typu landing page.

W praktyce podstawą programatycznego SEO jest to, że opiera się na bazach danych. Wszystkie informacje są zorganizowane w bazie danych, która następnie dynamicznie wypełnia szablon strony, aby stworzyć unikalne strony. Aspekty kreatywne związane z tworzeniem treści w zakresie programatycznego SEO praktycznie są pomijane. Kiedyś wykorzystywano powtórzenia treści, mieszacze słów, a także nastoletnich copywriterów, którzy na różnego rodzaju giełdach tworzyli pełne błędów treści za kilka złotych. Dziś cała treść może być oczywiście generowana przez AI. Jej celem nie jest jakość ani wartość merytoryczna. Staje się ona jedynie pustym nośnikiem wykorzystywanym na potrzeby SEO.

Jak wykorzystywane są tego typu bazy danych w ujęciu programatycznym? Przykładowo, lista hoteli na w serwisie booking-com jest wykorzystywana do tworzenia treści w formatach takich jak hotele {rodzaj hotelu/opis – np. luksusowe, dla rodzin} w {lokalizacja}. Połączenia samolotem w Expedii i podobnych źródłach łatwo można wyszukać m.in. dzięki zastosowaniu baz danych. Rezultaty pokazywane przez wyszukiwarkę wewnętrzną są następnie przetwarzane na dodatkowe strony po nasycaniu słów kluczowych, które wzbogacają wartość wyników wyszukiwania autorskiej wyszukiwarki. Podobnie działają bazy danych G2.

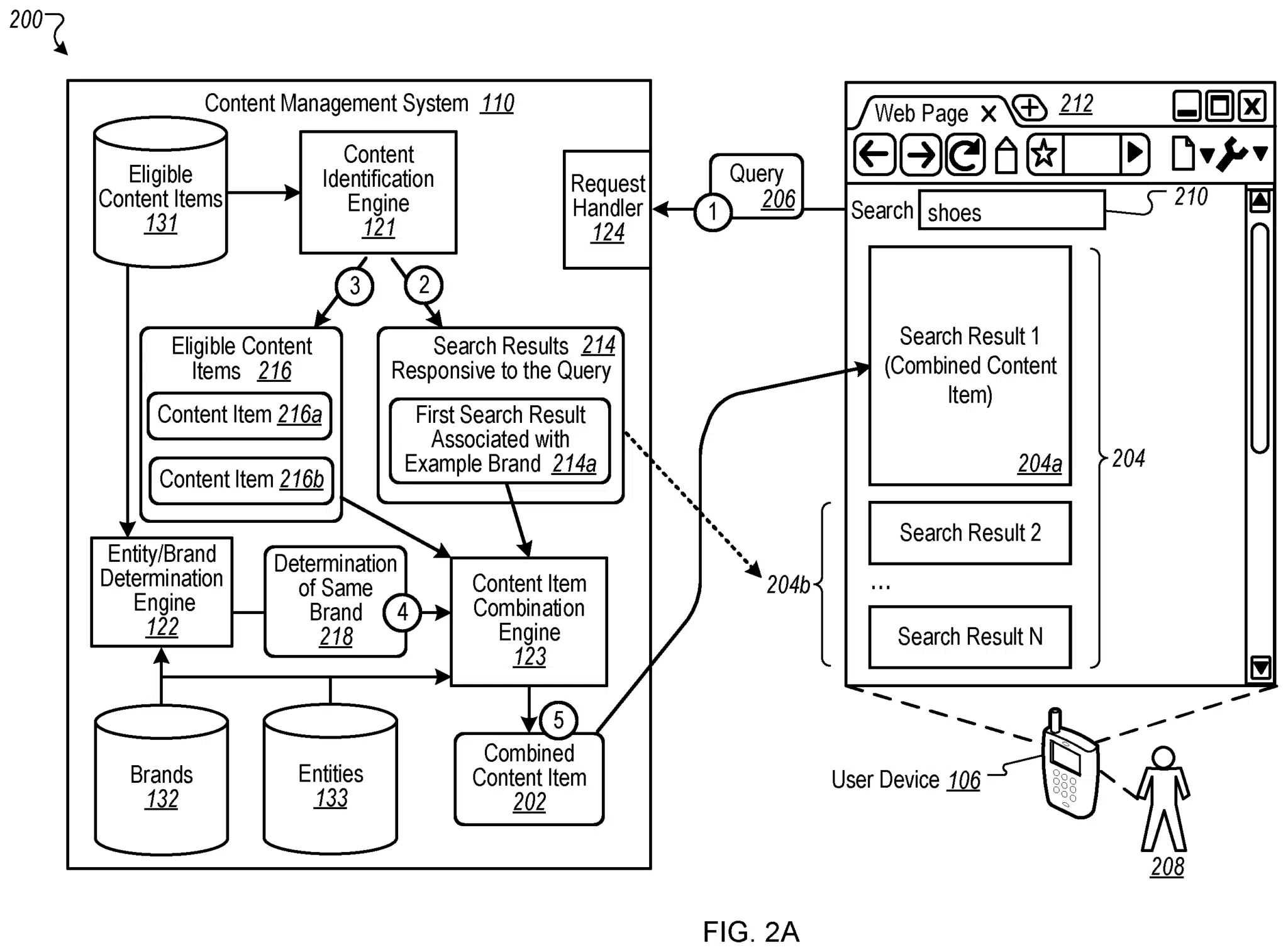

Wracając do funkcji szukania w wielu źródłach internetowych Google – system przede wszystkim potrzebuje danych. Google pobiera dane z najlepszych stron internetowych opartych na listach, kierując się wielkością strony internetowej i ogólnymi parametrami rankingowymi. Najczęściej są to strony internetowe należące do dużych koncernów medialnych. Jako że prowadzi to do dysproporcji w wynikach wyszukiwania, kontrowersje wokół polityki zasad etycznych Google rosną.

Zaledwie 1/4 wyników wyszukiwania to wiarygodne odnośniki

Skoro omówiliśmy już, w jaki sposób Google postanowiło wykorzystywać rozszerzone fragmenty, trzeba zadać sobie fundamentalne pytania: czy działania te faktycznie służą użytkownikom, czy interesowi Google?

W tym celu można przeprowadzić prostą analizę wyników. Sprawdzenie wiarygodności i jakości SERP możemy wykonać bez zewnętrznych narzędzi. Przełączamy się na amerykański Google, korzystając z wyszukiwarki w oknie prywatnym z VPN. Wybieramy frazę “najlepsi konsultanci SEO” i wybieramy funkcję SERP dotyczącą wielu źródeł. Wyświetlają się 24 sloty przeznaczone na dodanie konsultantów SEO. Wnioski są przerażające.

Tylko 14 z 24 slotów stanowi rzeczywiste wyniki; 10 slotów to podmioty lub organizacje, które albo nie pasują do promptu, albo zajmują się nieco innymi rzeczami. Spośród tych pierwszych 14 slotów 7 konsultantów nie prowadzi już praktyki, wobec czego ich zaznaczenie w wyszukiwarce wprowadza obecnie w błąd. Zostaje więc tylko 7 slotów, które faktycznie poprawnie odpowiadają na wpisany prompt. 7 z 24 to jedynie ~29% – bardzo mierny wynik.

Skoro wynik pod względem ilościowym z pewnością nie powala na kolana, to może chociaż wskazane rezultaty bronią się jakością? Może są to najlepiej wyselekcjonowane wyniki z całej listy wyników wyszukiwania?

Niestety, także pod tym względem czeka nas rozczarowanie. Rezultaty pokazywane przez Google w formie górnych snippetów mają bardzo słabą jakość. Google wybiera źródła, które wyraźnie nie pasują do zamiaru wyszukiwania i nie odróżnia niuansów, takich np., jak różnica między konsultantem SEO a konsultantem w ogóle (np. telefonicznym), czy między freelancerem a agencją.

Najdobitniej wybrzmieć powinny przyczyny tego zjawiska. Po pierwsze, Google czerpie informacje z nieautorytatywnych i niewiarygodnych stron zawierających linki sponsorowane lub spamujących inne witryny.

Jeżeli funkcja wyszukiwania z wielu źródeł w snippetach nie daje wymiernych rezultatów, należy zakładać, że lepiej będzie w samych wynikach wyszukiwania. To też każdy może zweryfikować. Dla pierwszych 80 wyników ponad 30 rezultatów to profile pracowników i firm na LinkedIn. Drugie tyle to artykuły blogowe na stronach firmowych i blogowych, np. Medium. Liczba wiarygodnych wyników wyszukiwania w SERP wynosi ok. 25%. Tak źle chyba nigdy nie było, jeśli chodzi o Google Search.

Ulepszenie wyszukiwarki, a może zwiększenie zysku Google?

Spróbujmy przeanalizować teraz, z czego wynika tak słaba jakość wyświetlanych przez Google wyników wyszukiwania. Zdroworozsądkowo pojawiają się trzy główne możliwości:

- Google ma odpowiednie zdolności do analizowania stron i źródeł, ale nie korzysta z nich w pełni ze względu na kosztowność procesu.

- Google ma odpowiednie zdolności do analizowania stron i źródeł, ale wybiera pokazywanie innych stron, bo jest to z jakiegoś tytułu opłacalne dla Google.

- Google nie ma odpowiednich zdolności do analizowania stron i źródeł.

Faktem jest, że zaawansowane procesy wyszukiwania, klasyfikowania i katalogowania zawartości stron internetowych są kosztowne. To znacznie więcej zasobów obliczeniowych, które przemnożone przez miliony wyszukiwań mogą robić różnicę, jeśli chodzi o optymalizację finansową działań Google. Ale przecież Google deklaruje jednoznacznie, jak istotny jest content, optymalizacja, schema itd.

Drugi powód jako główną przyczynę wskazuje nie kosztowność całego procesu, a ewentualną opłacalność takich działań wynikającą z innych źródeł. Nie jest to wcale teoria spiskowa, że Google współpracuje z koncernami medialnymi na zgoła innych zasadach, niż z indywidualnymi reklamodawcami Google Ads.

Trzecia interpretacja wskazuje, że Google wciąż nie jest w stanie analizować stron dokładnie, a przynajmniej nie w takim stopniu, jak wynika to z oficjalnych komunikatów. Ta interpretacja wydaje się być najbliżej prawdy. Warto zwrócić uwagę na to, że w trakcie trwającego postępowania antymonopolowego w UE przedstawiciele Google sami podkreślili, że mają ograniczone możliwość weryfikacji trafności wyników…

Google manipuluje widocznością firm w elementach rozszerzonych

Analizując anglojęzyczne wyniki powyższego testu, możemy sprawdzić, czy wyświetlane przez Google rezultaty promują witryny, które korzystają z programatycznego SEO. Jakiego rodzaju strony internetowe zazwyczaj inwestują w programowe SEO i czerpią z tego korzyści? Są to przede wszystkim duże przedsiębiorstwa z ogromnymi bazami danych, ponieważ to właśnie bazy danych są konieczne do tego, aby prowadzić tego typu działania. Spośród zagranicznych liderów pod tym względem wymienia się między innymi takie portale, jak Expedia, TripAdvisor, Skyscanner, Zapier, Canva, G2 i Clutch.

Nawiasem mówiąc, warto wspomnieć o tym, że przedstawiciele Expedii i Booking.com zeznawali przeciwko Google w najnowszym procesie antymonopolowym. Oskarżają oni organizację o monopolizowanie wyników wyszukiwania poprzez nieuczciwe promowanie swoich konkurencyjnych mikroorganizacji (takich jak Google Flights i Google Hotels) oraz wprowadzanie zmian na stronach wyników wyszukiwania, jednocześnie podnosząc ceny reklam, aby zepchnąć konkurencję na bok. Takie działanie, jeśli faktycznie zostanie udowodnione, spotka się z nałożeniem kar przez UE.

Łączy się to z drugą teorią związaną z opłacalnością. Zapytania oparte na listach są obecnie całkowicie podporządkowane płatnościom. Aby dostać się na wyniki tych snippetów, można albo zapłacić Google, albo stronie trzeciej, czyli któremuś z dużych wydawców medialnych, który ma potencjał umieszczenia naszej strony na setkach serwisów linkujących. Czy taka praktyka jest w pełni zgodna z zasadami etycznymi Google? Oczywiście, że nie, ale – jak widać – nikomu to nie przeszkadza.

Tym samym Google stara się o to, aby zapewniać rezultaty w oparciu o własne usługi płatne. Z jednej strony nie chce dopuścić do całkowitej dominacji serwisów opartych o praktyki link buildingu, które moglibyśmy zaliczyć do szarej strefy. Takie działanie również byłoby niezgodne pod kątem praw antymonopolowych, przynajmniej w obrębie UE. Z drugiej jednak strony Google robi wszystko, aby zmonetyzować te usługi.

Wyróżnione fragmenty w górnej części wyników wyszukiwania zyskują coraz większą popularność (rozumianą jako łączny wzrost liczby kliknięć). W 2017 roku otrzymywały średnio 8,6% kliknięć, z kolei w 2022 roku wynik uplasował się na poziomie 35,1%. To ponad czterokrotny wzrost częstotliwości korzystania z tych opcji przez użytkowników.

Jak Google przekierowuje ruch ze snippetów? Podsumowanie

Google sprzeciwia się stosowania zasad SEO wyłącznie jako narzędzi do uzyskiwania wyższych pozycji w SERP. Takie metody, jak SEO programatyczne (programmatic SEO) stanowczo potępia. Jednocześnie, jak pokazaliśmy powyżej, faworyzuje strony, które z tych technik korzystają. Ogromnym problemem jest to, że Google nie ma możliwości dokładnej analizy stron i treści w takim stopniu, który pozwoliłby na ich wiarygodną ocenę. Widać dużą dysproporcję między tym, co czytamy w Google Guides, a tym, co słyszymy od reprezentantów Google w trakcie trwającego procesu antymonopolowego w UE.

Gdy Google zainicjowało karuzele, od razu pojawiło się wiele głosów przeciwnych. Trudno się temu dziwić – nawet dobre rozwiązania na początku są zwykle krytykowane. Jednak ścieżka ewolucji snippetów i elementów rozszerzonych, którą obrało Google, jest co najmniej kontrowersyjna. Funkcja szukania z wielu źródeł sieci jest tego najlepszym przykładem, bo z definicji jest formatem programatycznego SEO, a nie funkcją, która bazuje na wysokiej jakości, oryginalnej treści.

Informacje w bazach danych Google’a, które informują o wyróżnionym fragmencie, wydają się nie być weryfikowane pod kątem faktów ani często aktualizowane. Nierzadko prezentują informacje z ograniczonej liczby źródeł niskiej jakości, które nie są zgodne z zamiarem wyszukiwania użytkownika. W rezultacie pierwsza pozycja często zajmowana jest przez witryny, które wcale nie mają realnej wartości dla użytkownika. Bardzo często są to portale należące do dużych sieci medialnych, co szczególnie dobrze widać w amerykańskim Google.

Pod wieloma względami cała konstrukcja elementów rozszerzonych w SERP stoi w sprzeczności z wytycznymi Google’a dotyczącymi jakości treści. Z tej perspektywy można zauważyć, że wyróżniony fragment ogranicza widoczność faktycznie wartościowych stron. Jego struktura i design nie dostarczają niezbędnego kontekstu dotyczącego zawartych elementów listy, ich związku z zapytaniem użytkownika i procesu wyboru elementów listy. Google nie ma jednak obecnie żadnych pomysłów, co można z tym zrobić, a patrząc na ewolucję elementów rozszerzonych od 2017 roku nie należy spodziewać się cudów.