Brak obecności strony w Google to poważny problem. Widoczność w najpopularniejszej wyszukiwarce na świecie bowiem znacząco przekłada się na ruch w witrynie, a co za tym idzie na konwersję. Jeżeli strona jest nowa, istnieje szansa, że dopiero czeka na indeksację. Tylko co zrobić, jeśli proces trwa niepokojąco długo? Inni z kolei pytają: „Dlaczego mojej strony nagle nie ma, skoro była?”. Przyczyn nieobecności bądź niespodziewanego zniknięcia witryny z listy wyników wyszukiwania jest wiele. Dziś omawiamy najpopularniejsze – poznaj je!

Spadek pozycji strony w wynikach wyszukiwania vs. całkowita utrata widoczności (brak obecności)

Na wstępie należy podkreślić różnicę pomiędzy całkowitym brakiem obecności strony internetowej w wynikach wyszukiwania Google (1), całkowitym brakiem obecności w indeksach wszystkich wyszukiwarek internetowych (2), częściowym brakiem widoczności, czyli konkretnych podstron bądź na wybrane słowa kluczowe (3) oraz spadkiem pozycji strony w wynikach wyszukiwania (4). Powody wszystkich tych sytuacji mogą być takie same, np. niedawne powstanie witryny, nieskuteczne i nieumiejętne działania SEO, niedozwolone praktyki pozycjonerskie. Mogą się jednak różnić.

- Jeżeli strona zniknęła z Google całkowicie, przyczyna może wynikać z jednego ze źródeł wymienionych w niniejszym artykule. Zapraszamy do lektury!

- Jeżeli witryna jest niedostępna w indeksach wszystkich wyszukiwarek internetowych, z listy potencjalnych przyczyn wyeliminuj kary Google, zablokowane roboty Google (plik robots.txt), ręczne działania ukazane w Google Search Console. Innymi słowy: odrzuć wszystko, co wiąże się bezpośrednio i wyłącznie z polityką wyszukiwarki Google.

- i 4. oznaczają, że domena wyświetla się w wynikach wyszukiwania, a problem występuje tylko z wybranymi podstronami. Przykładowi winowajcy to: aktualizacja algorytmu Google, nieskuteczne działania SEO, nieetyczne pozycjonowanie (Black Hat SEO), brak SEO, brak zmian na stronie, skuteczne działania SEO konkurencji, depozycjonowanie (Twojej) strony, nieresponsywność szablonu, filtr nałożony na stronę internetową: ręczny bądź algorytmiczny. Ponadto może się okazać, że nieobecność strony www na wybrane słowa kluczowe wynika z… błędnego sposobu sprawdzania. Otóż pozycje witryny różnią się – niekiedy znacząco – gdy hasło wyszukiwane jest na urządzeniu mobilnym, w innym mieście, przez osobę, która poszukuje hasła po raz pierwszy itd. Przeczytaj, jak poprawnie sprawdzić pozycję strony w Google.

Pamiętaj, że wahania pozycji strony www w wynikach wyszukiwania są jak najbardziej normalne. Dopiero kiedy cała domena nie wyświetla się w wynikach lub doszło do nagłych i drastycznych spadków pozycji, możesz uznać, że coś poszło nie tak.

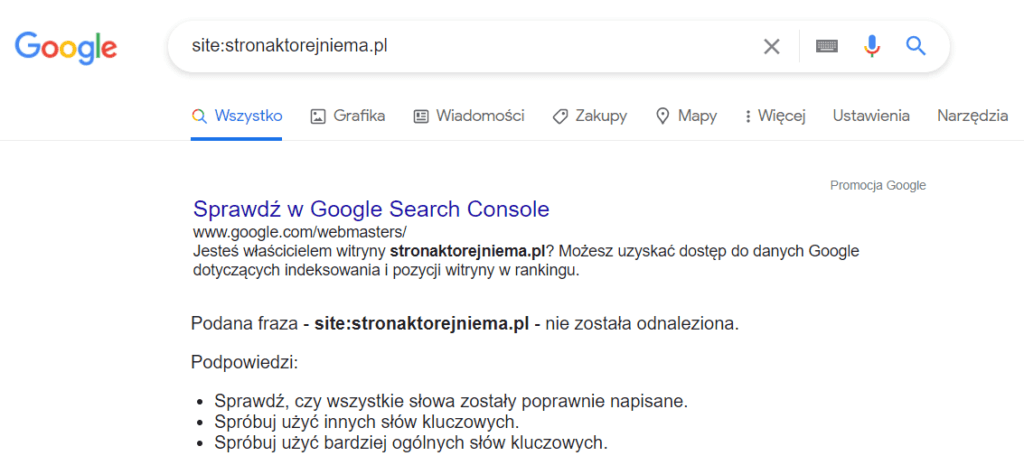

Jak sprawdzić, czy strona znajduje się w indeksie Google?

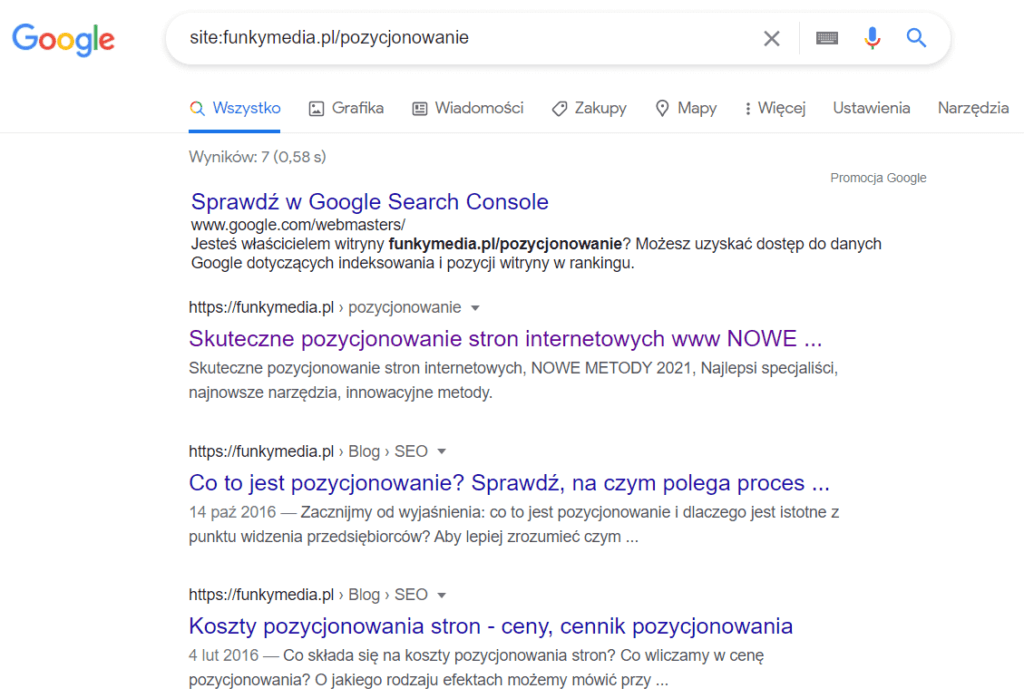

„Wydaje mi się, że mojej strony nie widać w Google, ale nie jestem pewien. Jak mogę to sprawdzić?” – pytają osoby z niewielką wiedzą w zakresie zarządzania stroną i SEO. Na szczęście weryfikacja widoczności domeny na liście wyników wyszukiwania jest bardzo łatwa i nie trzeba wykorzystywać do niej żadnych narzędzi. Otwórz wyszukiwarkę Google i w oknie wyszukiwania wpisz:

site:nazwa-strony.pl (oczywiście w nazwie strony umieść swoją)

W rezultacie powinieneś otrzymać odpowiedź w postaci listy podstron – wszystkich, które zostały zaindeksowane przez roboty Google. Sprawdź, czy na liście znajduje się podstrona, na której Ci zależy. Aby nie szukać jej ręcznie wśród licznych wyników, w komendzie „site:” wykorzystaj adres URL tej konkretnej podstrony i ponownie kliknij enter. Teraz powinieneś ją zobaczyć na szczycie wyników.

Google Search Console – ręczne działania, indeks słów kluczowych

Problemy z brakiem obecności strony w Google zweryfikujesz także w narzędziu Search Console. Zaloguj się do panelu i wybierz zakładkę „Skuteczność -> Wyniki wyszukiwania”. W tym miejscu możemy podejrzeć ogólną skuteczność witryny w docieraniu do potencjalnych użytkowników. Jeśli wykres jest płaski, a na liście słów kluczowych nie pojawia się żadne, witryna może nie być widoczna w Google.

W celu potwierdzenia przypuszczenia zajrzyj kolejno do zakładek:

- „Indeks -> Stan” – zweryfikuj status prawidłowo zaindeksowanych podstron. Liczba nie powinna wynosić 0,

- „Indeks -> Mapy witryn” – jeżeli przesłałeś mapę witryny, sprawdź, czy jest włączona i aktualna. Jeśli tego nie zrobiłeś, prześlij mapę teraz,

- „Indeks -> Usunięcia” – być może osoba mająca dostęp do narzędzia przypadkowo wyindeksowała podstrony? Upewnij się, że do tego nie doszło,

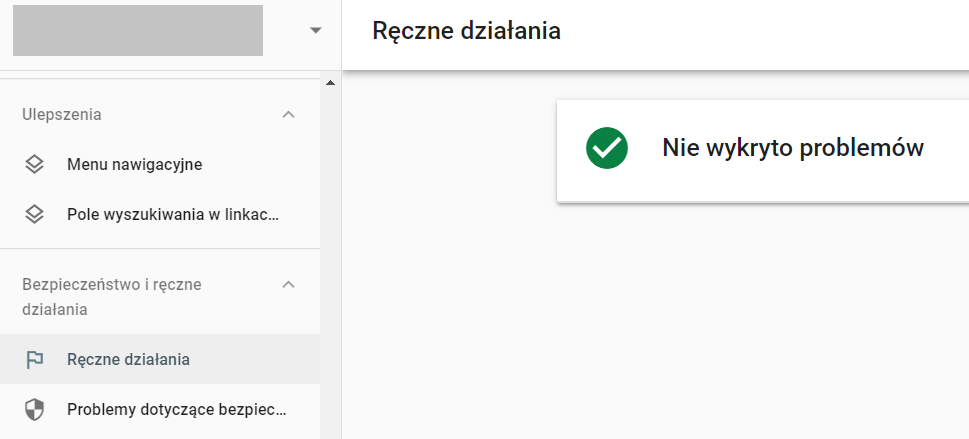

- „Bezpieczeństwo i działania ręczne” – o ile na stronie internetowej zaistniały problemy i zostały podjęte ręczne działania, w obu dostępnych tu podzakładkach – „Ręcznie działania” i „Problemy dotyczące bezpieczeństwa” – znajdziesz stosowne informacje.

Dlaczego doszło do wyindeksowania mojej strony? Czy to wynik kary Google?

Jednym z najjaskrawszych przykładów powodów braku obecności strony w Google jest usunięcie z indeksu w wyniku objęcia karą. Chodzi tu niestety o najsurowszą karę: bana. Zostaje nałożony wyłącznie z uwagi na problemy obecne w witrynie, nigdy zaś przez niedozwolone linki przychodzące. (Uwaga: może za to dotyczyć linków wychodzących ze strony, prowadzących do innych witryn: niskiej jakości, niebezpiecznych, zaspamowanych, nielegalnych).

Do usunięcia z indeksu Google zazwyczaj dochodzi na skutek prowadzenia Black Hat SEO, czyli pozycjonowania strony w sposób niezgodny z regulaminem tej wyszukiwarki, nieetyczny, mający na celu manipulowanie użytkownikami i/lub robotami Google – w obu przypadkach ze szkodą dla użytkowników. Jeżeli chcesz się dowiedzieć, za jakie konkretne działania możemy otrzymać bana, przeczytaj te dwa artykuły:

- Kary od Google – powody. Za co można je dostać?

- Pozycjonowanie: White Hat SEO, Black Hat SEO – czym są?

Przypadkowe wyindeksowanie strony w pliku robots.txt

Plik robots.txt to dokument zawierający informacje niedostępne dla zwykłego użytkownika strony. Takie, które może odczytać jedynie robot Google – bądź innej wyszukiwarki – po wejściu na stronę. Dzięki wskazówkom zawartym w pliku robots.txt roboty – crawlery – wiedzą, jak mają się zachować, jakie akcje mogą podjąć, czego zaś robić nie mogą.

Jeżeli w pliku robots.txt pojawi się komenda: „User-agent: * Disallow: /”, roboty Google i innych wyszukiwarek mogą zaniechać indeksowania witryny. Aby odblokować możliwość, wystarczy zamienić polecenie disallow na allow.

Uwaga! Plik robots.txt nie służy stricte do blokowania indeksacji stron/podstron, tylko plików. W efekcie witryna/podstrona może zostać wyindeksowana, ale wcale nie musi. Mimo obecności komendy disallow zostanie zaindeksowana chociażby w sytuacji, w której prowadzą do niej linki z innych podstron w domenie bądź spoza witryny. Niestety kiedy roboty umieszczą w indeksie podstronę z komendą disallow, wyświetli się na liście wyników wyszukiwania w sposób nieatrakcyjny: nie będzie miała tytułu, opisu ani zdjęcia. Użytkownicy nie będą chcieli jej klikać.

Meta name=”robots” content=”noindex”

Innym sposobem na zablokowanie robotów – tym razem skutecznym i zalecanym przez Google – jest wykorzystanie metatagu noindex w odniesieniu do danej podstrony. Sprawdź w kodzie HTML, w sekcji <head>, czy nie pojawiła się tam przypadkiem komenda: <meta name=”robots” content=”noindex”> (bądź <meta name=”robots” content=”noindex, nofollow”>). Jeżeli tak, usuń ją lub zamień polecenie noindex na index. Skutek będzie ten sam: pozwolisz robotom na ponowną indeksację witryny, dzięki czemu niebawem wróci na listę wyników wyszukiwania.

Nagłówek odpowiedzi HTTP: noindex

W poradniku Google dla webmasterów obok wykorzystania dyrektywy noindex w metatagu wyróżniono jeszcze jeden sposób na skuteczne zablokowanie indeksacji strony w Google. Tym razem nie dotyczy sekcji <head> kodu HTML, lecz nagłówka odpowiedzi HTTP. Jeżeli nagłówkowi X-Robots-Tag przypiszesz wartość noindex, strona zostanie zarejestrowana przez robota jako poprawna (kod 200), mimo tego nie doda jej do indeksu.

Przykładowy kod wygląda następująco:

HTTP/1.1 200 OK

(…)

X-Robots-Tag: noindex

(…)

Jeśli nie chcesz, by strona zniknęła z Google – bądź chcesz przywrócić ją po tym, jak już zniknęła – zadbaj o to, by w wyżej przytoczonym fragmencie kodu nie pojawiła się dyrektywa noindex.

Tymczasowe zniknięcie strony z Google – wyindeksowanie w Google Search Console

Do wyindeksowania strony z Google może dojść nie tylko poprzez samodzielne wprowadzenie zmian w pliku robots.txt czy użycie dyrektywy noindex. Jeżeli osoby opiekujące się Twoją witryną mają dostęp do narzędzia Google Search Console, mogły to zrobić również za jego pomocą.

Sprawdź, czy strona została tymczasowo wyindeksowana, zaglądając do zakładki „Indeks -> Usunięcia”. Jeżeli znajdziesz tu wysłaną i zaakceptowaną prośbę o tymczasową blokadę w wynikach wyszukiwania, anuluj ją. W przypadku braku anulowania dana podstrona samoistnie pojawi się w wynikach wyszukiwania po około pół roku od wysłania prośby.

Zabezpieczenie dostępu do strony internetowej hasłem

Strona internetowa nie może pojawić się w wynikach wyszukiwania, jeżeli dostęp do niej został zabezpieczony hasłem. W taki sposób skutecznie blokuje się robotom możliwość dotarcia do opublikowanych treści. Jeżeli więc Twoja domena – bądź wybrane podstrony – wymagają zalogowania, nie znajdziesz jej poprzez wpisanie słów kluczowych w wyszukiwarkę.

Uwaga! Jeżeli na Twojej stronie internetowej można zakładać konto, nigdy nie umieszczaj najważniejszych informacji – zwłaszcza bogatych w słowa kluczowe – w panelu dostępnym dopiero po zalogowaniu. Kluczowe teksty SEO opublikuj w miejscu, w którym będą dostępne dla wszystkich użytkowników, również tych niezalogowanych. Tylko w ten sposób bowiem dotrą do nich roboty i zyskają szansę poprawnego zaindeksowania podstron.

Sprawdzanie strony pod kątem różnych wyszukiwarek internetowych

„Mojej strony nie widać na liście wyników wyszukiwania, ale tylko w Google. Co mam zrobić?” – pytają ci, którzy weryfikację widoczności przeprowadzili w kilku różnych wyszukiwarkach. Wbrew pozorom jest to sytuacja korzystniejsza od zniknięcia ze wszystkich wyszukiwarek jednocześnie. Masz do sprawdzenia mniej potencjalnych przyczyn. Zweryfikuj:

- ręczne działania w Google Search Console,

- prośby o tymczasowe wyindeksowanie w Google Search Console,

- informacje o trwających lub ukończonych w ostatnim czasie aktualizacjach algorytmu,

- plik robots.txt, w którym mogło dojść do zablokowania wyłącznie robotów Google („User-agent: Googlebot Disallow: /”).

Strona jest nowa – kiedy trafi do wyszukiwarki Google?

To, że strona jest nowa, może wyjaśniać, dlaczego nie widać jej na liście wyników wyszukiwania. Po prostu crawlery jeszcze nie zdążyły jej odwiedzić. Kiedy na nią trafią, witryna internetowa zostanie umieszczona w indeksie. Tylko ile czasu to zajmie…?

Możemy „zaprosić” roboty na naszą stronę i tym samym przyspieszyć proces indeksacji. Dodawaniu witryny do Google – a także dodawaniu pojedynczych podstron i informowaniu robotów o zmianach na stronie – poświęciliśmy artykuł, w którym omówiliśmy kilka łatwych sposobów. Zachęcamy do zapoznania się z nim: Jak dodać stronę do Google?

Strona zniknęła z Google na urządzeniach mobilnych

Twoja witryna internetowa zniknęła z wyszukiwarki jedynie na urządzeniach mobilnych? Może to oznaczać, że algorytm Google uznał ją za niedostosowaną do małych ekranów. W takim przypadku niezbędne będzie przebudowanie strony w celu poprawy jakości i wdrożenie responsywności.

Możemy też założyć mobilną wersję strony, chociaż rozwiązanie to jest gorsze od zainwestowania w serwis responsywny. Należy bowiem wiedzieć, że responsywność stanowi cechę, dzięki której strona jest łatwiejsza do obsługiwania nie tylko na telefonach, ale również na tabletach, laptopach o zróżnicowanych przekątnych ekranu, telewizorach, ekranach zewnętrznych itd.

Zapoznaj się ze specyfikacją stron responsywnych, a także dowiedz się, czym właściwie strona responsywna różni się od mobilnej.

Strona zniknęła z Google – działu grafiki

Plik robots.txt zawiera różne polecenia dla robotów, w tym dotyczące plików wizualnych i audiowizualnych. Jeżeli Twoja strona nie wyświetla się jedynie w dziale grafiki Google, wśród wyników tekstowych zaś owszem, przyczyny możesz szukać właśnie tutaj. Sprawdź, czy plik robots.txt zawiera komendę: „User-agent: Googlebot-Image Disallow:”. Jeżeli tak – wykasuj ją.

Poproś webmasterów o weryfikację potencjalnej blokady grafiki także w innych miejscach, np. bezpośrednio w CMS-ie – we wtyczkach. Wtyczki SEO, takie jak Yoast, pozwalają na zablokowanie wybranych zasobów i podstron (grafiki, archiwum, tagów, tagów autorskich itd.). W efekcie strona nie wyświetla się tylko częściowo.

Strona nie wyświetla się w wynikach wyszukiwania przez brak treści

W większości przypadków brak treści na stronie prowadzi do małej widoczności, nawet na słowo kluczowe z bardzo długiego ogona. Może się jednak zdarzyć, że kiedy strona zawiera minimalną ilość treści, a dodatkowo zajdą inne okoliczności sprzyjające, zostanie usunięta z indeksu Google.

Aby przywrócić swoją stronę na dobre pozycje, pamiętaj o regularnym tworzeniu unikalnych, wartościowych treści. Oczywiście sama pamięć nie wystarczy – musisz się jeszcze uczciwie, rzetelnie zastosować. Twórz i rozbudowuj opisy usług, produktów, kategorii. Nie zastępuj tekstów pisanych w języku HTML animacjami ani treściami umieszczanymi w obrazach i filmach. Niestety crawlery nie są w stanie odczytać danych innych niż tekstowe. W takim przypadku naszą stronę mogą uznać za pustą, co ponownie doprowadzi do ograniczenia widoczności bądź usunięcia z wyników wyszukiwania.

Ukrywanie treści (cloaking) – kiedy roboty Google widzą inną treść

Ukrywanie i maskowanie treści – zarówno przed użytkownikami, jak i przed robotami – to praktyki surowo zabronione w przygotowanym przez Google poradniku dla webmasterów. Za ich stosowanie grozi całkowite zredukowanie widoczności w popularnej wyszukiwarce. Jeśli chcesz uniknąć kary, upewnij się, że kod HTML nie zawiera treści, które zostały celowo schowane przed użytkownikami. Nie zapisuj tekstu białymi literami na białym tle. Jeżeli ktoś dał Ci taką poradę SEO, raczej nie chce dla Ciebie najlepiej. Nigdy nie maskuj zdjęć w celu przekonania robotów, że widać na nich coś innego niż zawierają w rzeczywistości.

Uwaga! Jeśli padłeś ofiarą hakerów, koniecznie sprawdź – bądź poproś webmasterów – o zweryfikowanie kodu HTML. Zdarza się, że to właśnie wtedy w kodzie zostają ukryte treści (zwłaszcza linki). W rezultacie Twoja strona znika z Google, a Ty nie masz pojęcia dlaczego.

Szybkość ładowania witryny a obecność w wynikach wyszukiwania Google

Podobnie jak brak treści czy korzystanie z nieresponsywnego szablonu, nieoptymalna prędkość ładowania witryny internetowej bezpośrednio i negatywnie wpływa na wyniki wyszukiwania. Strona, która wczytuje się bardzo wolno, a odwiedzający ją użytkownik czy robot w pierwszym widoku otrzymuje wyskakujące okna z zapisem do newslettera, paski z polityką prywatności, wigdety social media, czaty i inne pop-upy, powoli wędruje w dół indeksu Google. W końcu może zniknąć zupełnie, jeżeli zostanie uznana za bezwartościową.

Spam jako winowajca faktu, że strona zniknęła z Google

Zaspamowane strony internetowe również uznawane są za niskiej jakości. I to niekoniecznie w wyniku działań właściciela! Równie dobrze może chodzić o spam na stronie tworzony przez użytkowników. Jeśli posiadasz sekcje komentarzy, recenzji i opinii, koniecznie je moderuj. Nie pozwalaj na używanie przekleństw, poruszanie drażliwych kwestii ani wykorzystanie słów, które mogą wzbudzić podejrzenia algorytmu (związanych z branżą pornograficzną, hazardową itp.). Także w sytuacji, w której swoją stronę rozbudowałeś o forum lub inną platformę służącą do publikowania wypowiedzi (np. miniblogi/dzienniki użytkowników), zatrudnij osoby do moderacji.

Strona zniknęła z Google w wyniku zaprzestania działań SEO

W większości przypadków strony z regularnie wykonywanymi działaniami SEO pokazują się w indeksie Google, i to na korzystnych pozycjach. Jeżeli jednak pozycjonowanie zostanie zatrzymane na długi czas lub przerwane, pozycje witryny będą spadać, aż serwis – w skrajnej sytuacji! – zniknie z wyszukiwarki.

Uwaga! Kompletny brak działań SEO czy zaprzestanie pozycjonowania rzadko skutkuje wyindeksowaniem strony internetowej. Najczęściej prowadzi do znacznego ograniczenia widoczności. Innymi słowy: Twoja strona nie zniknęła z Google, lecz zajmuje pozycje wykraczające poza pierwszą setkę i to właśnie z tego powodu nie generuje ruchu organicznego. Mimo iż oficjalnie nie zostałeś usunięty z indeksu, doświadczasz przykrych skutków wyindeksowania.

Strona zniknęła z Google przez brak aktualizacji

Brak działań SEO może pokryć się z brakiem aktualizacji informacji na stronie. Podczas ustalania pozycji w indeksie algorytm Google bierze pod uwagę m.in. częstotliwość pojawiania się nowych treści. W przypadku, w którym treści nie są publikowane wcale, na dodatek w witrynie nie zmienia się nic, Google może uznać stronę za porzuconą i w efekcie wykreślić ją z indeksu.

Taka sytuacja ma miejsce rzadziej w odniesieniu do sklepów internetowych czy blogów, częściej zaś do stron wizytówkowych i usługowych. Na tych drugich nie występuje rotacja produktów, ponieważ oferta jest stała. Jeśli strona nie ma bloga, nie dzieje się na niej zupełnie nic. Wystarczy jednak, że zadbasz o stały dopływ treści – chociażby poprzez rozbudowę istniejących już opisów – a utrzymasz widoczność w wyszukiwarce. Na dodatek dzięki publikowaniu treści możesz co jakiś czas wykorzystać na stronie nowe słowo kluczowe i dotrzeć do użytkowników, którzy wcześniej Cię nie znali!

Strona nie pojawia się w indeksie Google z uwagi na złośliwe oprogramowanie

Podstawowe informacje o problemach z bezpieczeństwem na stronie znajdziesz w Google Search Console („Bezpieczeństwo i działania ręczne -> Problemy dotyczące bezpieczeństwa”). Nie o wszystkich jednak powiadomi Cię to narzędzie – najlepiej skontaktuj się z webmasterami.

Jeżeli strona nie wyświetla się w wynikach wyszukiwania z uwagi na problemy z bezpieczeństwem, mogłeś paść ofiarą ataku hakerskiego. Być może nie dopilnowałeś aktualizacji narzędzi: CMS-a, wtyczek, szablonów, a hakerzy wykorzystali dziurę w kodzie. Istnieje też ryzyko, że zainfekowałeś stronę, wgrywając niesprawdzone pliki. Przeskanuj zasoby pod kątem wirusów i różnego rodzaju złośliwego oprogramowania.

Zhakowane strony internetowe znikają z indeksu Google

Atak hakerski może doprowadzić do wyindeksowania strony internetowej z Google, ale nie tylko z uwagi na wgranie złośliwego oprogramowania. Haker dysponujący pełnym dostępem do strony jest zdolny do usunięcia witryny. W ten sposób zniknie nie tylko z wyszukiwarki Google i innych, ale także z internetu w ogóle.

Skasowanie strony jest jednak mało opłacalne z perspektywy hakera, zwłaszcza gdy serwis cieszy się dobrą pozycją w wynikach wyszukiwania. W większości przypadków atakujący zdecyduje się na wykorzystanie witryny w celu promowania innej strony, np. wstawiając w kod HTML linki niewidoczne dla właściciela. Niezwykle ważne jest więc, by po ataku hakerskim oddać stronę w ręce doświadczonych webmasterów, którzy usuną zgubne skutki ataku – także te ukryte, w wyniku których mógłbyś nieumyślnie złamać regulamin Google i otrzymać bana.

Blokada stron internetowych z poziomu serwera

Pomoc webmasterów bądź pracowników firmy hostingowej, z której usług korzystasz, przyda Ci się również w przypadku zablokowania widoczności w wyszukiwarce z poziomu serwera. Jeśli padłeś ofiarą hakerów, Twój host mógł czasowo zablokować stronę, by wchodzący na nią użytkownicy nie pobrali szkodliwego oprogramowania. Usunięcie skutków ataku i przywrócenie działania witryny niekoniecznie będzie oznaczało powrót widoczności.

Drugi rodzaj problemu indeksacji na poziomie serwera wynika z zablokowania przez hosta jedynie robotów. Jeśli ktoś podjął próbę włamania na serwer, w efekcie którego odnotowano tysiące żądań na sekundę, wystarczyło zablokować jedynie roboty, by użytkownicy nadal mogli korzystać ze strony. Niestety w ten sposób odcięto także dobre roboty indeksujące.

Zaloguj się na serwer przez FTP i odnajdź plik .htaccess. Poszukaj w nim blokady robotów indeksujących. Musisz jednak znać nazwy robotów, aby omyłkowo nie usunąć blokady, która jest korzystna i chroni stronę.

Inne hostingowe przyczyny nieobecności strony w wyszukiwarce to np. błędy konfiguracji domeny czy samego serwera. W tym przypadku jednak weryfikacja usterki jest dość łatwa: pod wpisaniu adresu URL w przeglądarkę witryna w ogóle się nie pojawia.

Błędnie zastosowane słowa kluczowe

Jeżeli w wyszukiwarce nie wyświetlają się jedynie wybrane podstrony domeny, problem dotyczy wyłącznie ich. Przede wszystkim sprawdź, czy nie zostały zablokowane poprzez metatag noindex w kodzie HTML ani za pomocą wtyczki do CMS-a. W przypadku braku blokady zweryfikuj, czy owe podstrony pojawiają się w indeksie Google po wpisaniu komendy: „site:nazwa-strony.pl/dokładny-adres-podstrony/”. Otrzymanie odpowiedzi pozytywnej świadczy o fakcie, że technicznie z witryną jest wszystko w porządku – została zaindeksowana.

Dlaczego więc Twoja oferta czy artykuł nie pojawia się w Google, kiedy wpisujesz interesujące Cię słowo kluczowe? Zdawałoby się, że trafiłeś na niszowe zagadnienie i powinieneś osiągać spektakularne efekty, tymczasem wyszukiwarka uparcie nie wyświetla Twojej strony internetowej. Jak to możliwe?

Przyczyną może być błędne użycie słów kluczowych. Roboty Google są w stanie zrozumieć kontekst wypowiedzi, więc nawet jeśli konkretne słowo kluczowe nie padnie w tekście, masz szansę pojawić się na nie w wynikach wyszukiwania. Niestety nie jest to możliwe, jeżeli zupełnie pominiesz kontekst. Przykładowo możesz napisać perfekcyjny opis chust do noszenia dzieci. Jeżeli jednak nie poświęcisz choćby jednego akapitu wykorzystaniu chust do noszenia zwierząt, strona nie trafi do indeksu na słowa kluczowe związane z chustami do noszenia psów, kotów, szczeniaków, kociąt itd.

Nie widać strony w Google przez błędy odpowiedzi HTTP

Prawdopodobnie znane są Ci kody HTTP 404, 301 czy 300. Powinieneś jednak wiedzieć, że absolutnie każda strona – nawet poprawna – zwraca robotom jakiś kod odpowiedzi. W przypadku prawidłowo działającej podstrony mówimy o kodzie 200. Oczywiście sprzyja on indeksacji.

Kod odpowiedzi 30o i 301 to informacja dla robota, że zamiast tej strony zaindeksowana ma zostać inna. Z kolei kody zaczynające się cyfrą 4 generują problemy. Przykładowo kod odpowiedzi 401 stanowi wskazówkę, że aby dostać się na stronę, trzeba uzyskać autoryzację (np. wpisać hasło). 403 powiadamia o bezwarunkowej blokadzie dostępu do zasobów. Najbardziej znany kod 404 oznacza niemożność znalezienia zasobów pod danym adresem URL. W przypadku dużych i popularnych serwisów zdarza się też kod 503, czyli świadectwo przeciążenia serwera, przez co żaden użytkownik ani robot Google czy innej wyszukiwarki nie może się dostać na stronę do czasu odciążenia.

Im dłużej na stronie internetowej występuje dany błąd kodu HTTP, tym większa szansa, że owa strona – lub dana podstrona z błędem – zostanie wyindeksowana z wyszukiwarki. Listę problematycznych podstron zweryfikujesz np. w narzędziach Screaming Frog, Ahrefs, Majestic. Więcej na ten temat dowiesz się z pokrewnego artykułu: Sprawdzanie linków do strony – jak to robić?

Strona zniknęła z Google częściowo lub całkowicie? Zadbaj o SEO z pomocą specjalistów!

Twoja strona przestała pojawiać się w wyszukiwarce z uwagi na brak działań SEO, nieumiejętne, samodzielne pozycjonowanie bądź nieetyczne próby przechytrzenia algorytmu? Możemy Ci pomóc. Powierz nam wybrane aspekty SEO lub zleć całość działań.

Przygotujemy raport na podstawie audytu witryny i analizy konkurencji. Opracujemy strategię rozbudowy serwisu o nowe treści ze słowami kluczowymi. W końcu zadbamy o sukcesywne pozyskiwanie bezpiecznych, wartościowych linków. Dzięki nam na pewno nie znikniesz z wyników wyszukiwania. Ba! odnotujesz wzrosty pozycji.

Pozycjonowanie oznacza długofalowy proces, dzięki któremu strona staje się coraz lepsza. Obecnie, kiedy firmy masowo przenoszą się do internetu, jakość i widoczność witryny stają się szczególnie ważne – niekiedy jest to „być albo nie być” dla firmy. Należy zadbać o obecność w wynikach wyszukiwania Google, a także w innych miejscach, np. social media.

W związku z powyższym poza usługą pozycjonowania oferujemy SEO PR, tworzenie reklam na Facebooku i w Google Ads, doradztwo marketingowe. Jeżeli nie wiesz, które działanie sprawdzi się w odniesieniu do Twojej firmy i strony internetowej, nie szkodzi. Skontaktuj się z nami, a wspólnie znajdziemy najlepsze rozwiązanie.

Porady dla webmasterów – optymalizacja SEO, tworzenie treści, pozyskiwanie linków, reklamy

Na koniec zachęcamy Cię do zagłębienia się w artykułach publikowanych na naszym blogu. Poświęcamy uwagę tematom związanym z szeroko pojętym marketingiem w internecie. Znajdziesz tu mnóstwo sposobów na to, by strona nie zniknęła z Google, lecz odwrotnie: wędrowała w górę indeksu i trafiła do TOP 10. Przekonasz się też, jak zadbać o widoczność strony internetowej w innych miejscach sieci.

Prostych działań SEO możesz się podjąć samodzielnie. Prowadzenie bloga, rozszerzanie opisów produktów, umieszczanie na serwerze jedynie zmniejszonych i „odchudzonych” obrazków czy pozyskiwanie linków z komentarzy i wypowiedzi na forach to rzeczy, za które warto zabrać się od zaraz. Algorytm Google niewątpliwie je doceni, Ty zaś odnotujesz wzrost konwersji.