Każdego dnia powstają miliony nowych stron internetowych. Indeksowanie ich w wyszukiwarce przy jednoczesnym ograniczeniu sposobu wyświetlania wyników wyszukiwania sprawia, że coraz trudniej jest wypozycjonować nową stronę. Również doświadczeni właściciele stron o ugruntowanej renomie stykają się z większymi problemami z roku na rok. Na bazie danych Ahrefs okazuje się, że aż 96,55% stron internetowych nie zdobywa w ogóle ruchu organicznego z Google. W tym artykule sprawdzamy nie tylko, z czego to wynika, ale również co można zrobić, aby zwiększyć swoje szanse na widoczność.

Bezprecedensowy wzrost liczby stron internetowych na świecie

Tim Soulo, CMO w Ahrefs, stwierdzi, że crawlery Ahrefs przeszukują strony internetowe co dwie minuty. Według danych firmy stojącej za jednym z najlepszych narzędzi do analizy SEO Content Explorer od Ahrefs odkrywa nawet 10 milionów nowych witryn internetowych dziennie. Przyrost nowych stron internetowych w internecie wydaje się mieć charakter logarytmiczny. Witryn z roku na rok przybywa coraz więcej, a wszystko dzieje się w oszałamiającym tempie.

Chociaż Google odeszło już od sztywnego podejścia ograniczonych stron wynikowych (TOP 10) na rzecz modelu z wykorzystaniem scrollowania, miejsce w wyszukiwarce jest ograniczone. Z analizy doświadczeń użytkowników wiemy, że ponad 90% użytkowników nie scrolluje wyników wyszukiwania. To znaczy, że zdecydowana większość internautów zadowala się treściami z pierwszych wyników organicznych, reklam Google ADs, albo informacjami z elementów rozszerzonych i snippetów.

Wiadomo nie od dziś, że znalezienie się w “topce” bez wsparcia Ads staje się coraz trudniejsze. W przypadku wielu specyficznych branż bez dużego kapitału na długoterminowe działania SEO proces ten nie ma żadnych szans. A nawet z dużym budżetem nie ma nigdy gwarancji sukcesu.

Większość stron internetowych nie pozyskuje ruchu z Google

Ogromny przyrost nowych stron internetowych skłania do zadania pytania, jak wiele stron internetowych w ogóle jest odwiedzanych poprzez Google? Inaczej mówiąc, jaki odsetek witryn zdobywa ruch organiczny z wyników wyszukiwania Google?

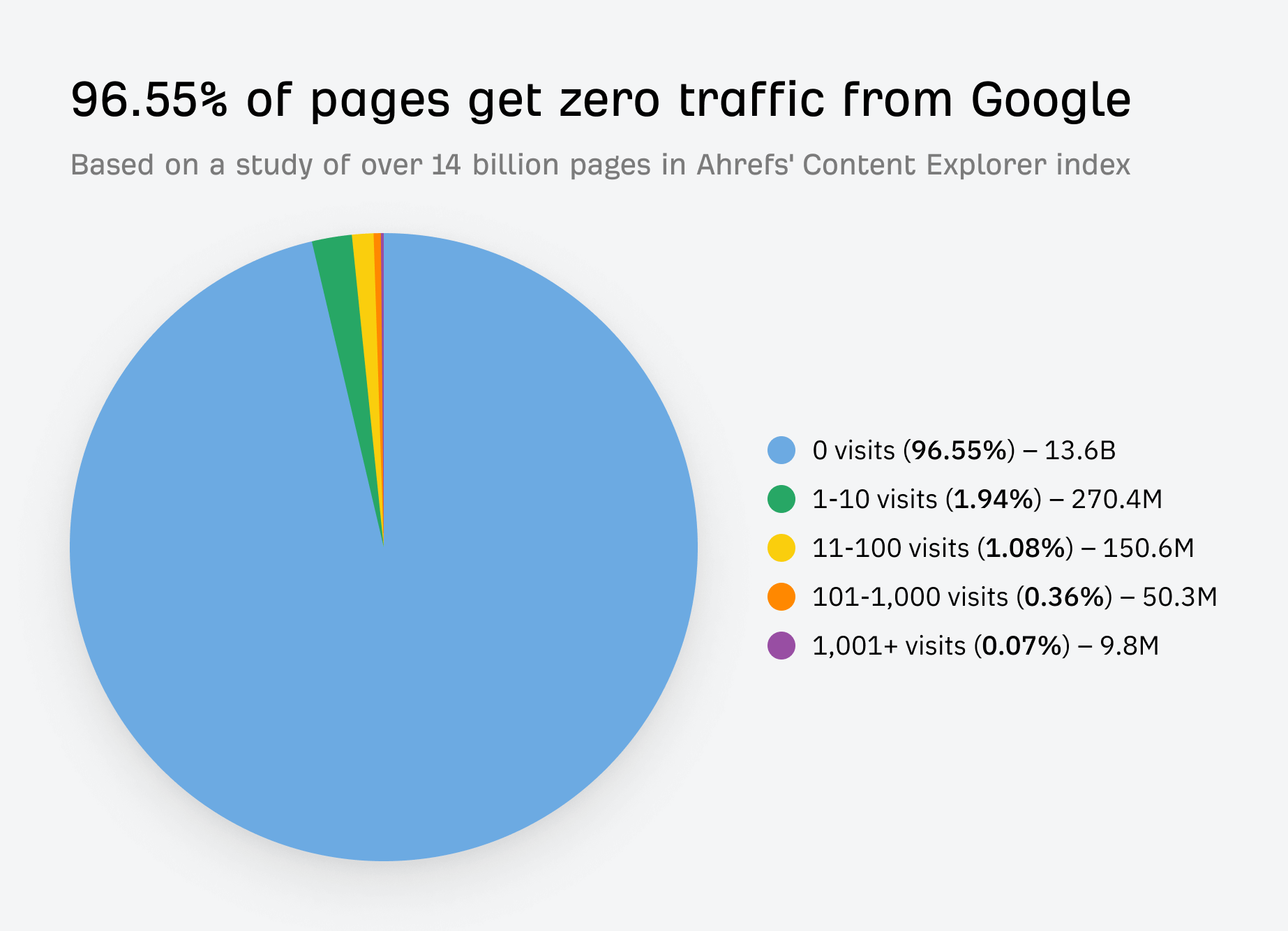

Aby to zbadać, zespół z Ahrefs skorzystał ze swojego narzędzia, Content Explorera, w celu przeanalizowania ponad 14 miliardów stron. To dwa razy więcej niż łączna liczba mieszkańców planety Ziemia.

Wyniki są wstrząsające. Według zespołu z Ahrefs 96,55% stron internetowych w ogóle nie uzyskuje ruchu z Google. 1,94% użytkowników odnotowuje ruch na poziomie od 1 do 10 odwiedzin strony na miesiąc. Na ruch przekraczający 1000 odwiedzin mogą liczyć szczęśliwcy: 0,07% wszystkich stron internetowych.

Oczywiście to, że strony nie pozyskują ruchu z Google, nie oznacza, że nie pozyskują ruchu z innych źródeł. Wymienić należy przede wszystkim bezpośrednie odnośniki z innych stron i z mediów społecznościowych. Z biegiem lat wolno, ale jednoznacznie rośnie również na rynku udział wyszukiwarki Microsoft Bing. Niemniej jednak badanie przeprowadzone przez Ahrefs skutecznie pokazuje, że wciąż znamienita większośc stron internetowych po prostu nie jest w stanie się przebić, a poprzeczka zawieszona jest bardzo wysoko.

Metodologia badania Ahrefs

Badanie Ahrefs unaoczniło także pewne rozbieżności, których wyjaśnienie jest kluczowe w celu analizy przyczyn sytuacji, kiedy strona nie zdobywa ruchu z wyszukiwarki. Ahrefs nie przeprowadziło badania na całej dostępnej próbie. Trudno zresztą taką zoperacjonalizować zwłaszcza w kontekście tak gigantycznego przyrostu nowych stron internetowych. Główny indeks Ahrefs i prawdopodobnie największy w posiadaniu przez prywatną firmę zewnętrzną, która nie jest wyszukiwarką, to Site Explorer z katalogiem liczącym 340 miliardów stron internetowych. Próba badawcza w postaci 14 miliardów stron nie jest na tym tle duża, bo stanowi jedynie 4,12% całego indeksu Site Explorer.

Kolejne zastrzeżenie dotyczy metodologii operowania bazy Site Explorer, która powstaje poprzez analizę ponad 651 milionów słów kluczowych. Pomimo tego, że są to ogromne operacje, z pewnością nie wyczerpują wszystkich możliwych konfiguracji wykorzystywanych przez rzeczywistych użytkowników, w związku z czym nie stanowią reprezentacji całego zbioru istniejących, opublikowanych stron internetowych. Z oczywistych powodów pomija się również strony wykorzystujące inne protokoły danych, strony niedostępne dla użytkowników z poziomu wyszukiwarki (Deep Web) i witryny z Dark Web.

Pomimo tego można przyjąć, że badanie wykonane przez zespół Ahrefs jest rzetelne z naukowego punktu widzenia, a rezultaty badania mogą być swobodnie ekstrapolowane. Wnioski są więc jednoznaczne: zdecydowana większość opublikowanych stron nigdy nie zajmuje pozycji w Google i nie otrzymuje żadnego ruchu organicznego.

Większość stron związana jest z tematyką, którą użytkownicy się nie interesują

Fakt, że jedynie 96,55% stron internetowych zdobywa ruch organiczny z Google, ma kilka różnych przyczyn. Jedną z najważniejszych jest to, że większość witryn po prostu nie jest odpowiednio przystosowana do obszarów, którymi interesują się użytkownicy. Może to wskazywać na dużą dysproporcję między popytem a podażą.

W raporcie Ahrefs wskazuje się przykładowo na frazę „pull sitemap into google sheets”. Według raportu Ahrefs pierwsza strona na liście wyników nie otrzymuje żadnego ruchu z Google. Jest jednak w pełni poprawna i zaindeksowana w Google, i można z niej korzystać. Analogicznie dzieje się z milionami innych stron, które czekają na użytkownika docelowego, a brak ruchu wynika z tego, że użytkownicy po prostu nie wpisują danych słów kluczowych bądź robią to bardzo rzadko.

Z tego powodu tak istotne jest przeprowadzanie badań słów kluczowych w procesie pozycjonowania stron. Biorąc pod uwagę specyfikę naszego polskiego rynku, problem ten jest jeszcze bardziej dostrzegalny ze względu na aspekty demograficzne oraz językowe. Strony w języku angielskim, francuskim czy hiszpańskim znacznie łatwiej są w stanie zdobywać popularność niż strony w językach mniejsze grupy narodowe.

Linki to wciąż podstawa

Backlinki są jednym z trzech najważniejszych czynników rankingowych Google, więc prawdopodobnie nie dziwi fakt, że istnieje wyraźna korelacja między liczbą witryn linkujących do strony a jej ruchem. Trzeba jednak pamiętać, że korelacja to nie to samo, co przyczynowość. Nie zmienia to faktu, że większość specjalistów SEO uznaje, że prawie niemożliwe jest zajęcie pierwszej strony wyników dla konkurencyjnych słów kluczowych bez backlinków. Ta obserwacja jest zgodna z rezultatami badania przeprowadzonego przez Ahrefs.

Kolejną obserwacją na podstawie badanie jest to, że wiele stron nie otrzymuje dość dużo ruchu nawet wtedy, gdy posiada rozwinięte linkowanie wewnętrzne i zewnętrzne oraz dużą ilość odnośników ze stron trzecich. Linki nie są bowiem nigdy gwarancją skuteczności, a niewłaściwie dobrane mogą też działać na niekorzyść strony internetowej, obniżając jej pozycję w rankingu.

Niemniej jednak wnioski są dość oczywiste: tylko 1 na 6671 stron bez linków zewnętrznych otrzymuje ruch organiczny z Google. Badanie dowodzi też po raz kolejny słuszności tezy, że linki bezpośrednio przekładają się na siłę domeny (domain rating, DR). Ta metryka pokazuje względną siłę profilu backlinków witryny. Silniejsze witryny, takie jak te, posiadają więcej PageRank, który mogą przekazać stronie za pomocą wewnętrznych linków, pomagając jej w rankingu.

Pod tym względem więc, jeśli chcemy pozyskać więcej ruchu z wyszukiwarki bez korzystania z reklamy PPC, musimy zdecydować się albo na rozbudowę stronę w zakresie tematów, które mają wysoki poziom popytu (wyszukiwania słów kluczowych), ale niski poziom konkurencji, albo budowanie strategii linkowania. Najlepiej oczywiście: jedno i drugie.

Treść niezgodna z intencją użytkownika

Przez większość naszych artykułów poświęconych najnowszym aktualizacją algorytmów Google pojawia się teza, że Google chce dostarczać użytkownikom najbardziej trafne wyniki dla zapytania. Pojawia się, gdyż to Google cały czas o niej przypomina. Wbrew pozorom jednak sposób dopasowywania wyników wyszukiwania do promptu po procesie jego zoperacjonalizowania wciąż stanowi chyba tzw. wąskie gardło, jeśli chodzi o jakość procesu wyszukiwania. Efekty? Nadmiar stron, które prezentują tematykę bądź treści, które nie są zgodne z intencją użytkownika wpisującego dany prompt.

Najczęstszy przykład tego typu zjawiska znajdziemy w wyszukiwaniu produktowych słów kluczowych. Google wciąż ma trudności w poprawnym zidentyfikowaniu intencji użytkownika: czy chcemy znaleźć informacje o produkcie, czy konkretne oferty dotyczące możliwości zakupu tego produktu? W takich sytuacjach wysokiej jakości treści na stronie czy odpowiednie backlinki raczej nie pomogą. Jeśli Google uzna, że wpisując w wyszukiwarce frazę “najlepsze maty do jogi” jesteśmy w fazie researchu, a nie zakupów, to bez względu na to, jak dobrze zrobione są sklepy internetowe sprzedające maty, pojawią się wpisy blogowe związane z informacjami o matach do jogi. Ewentualnie możemy liczyć na artykuły w formie rankingów z odnośnikami do poszczególnych produktów.

96,55% stron nie pozyskuje ruchu z Google. Podsumowanie

Analiza przeprowadzona przez Ahrefs daje do myślenia. W świetle powyższych danych można mówić o tym, jak istotny wpływ na zdobywanie ruchu z Google wciąż mają backlinki, których z pewnością nie może zabraknąć w działaniach SEO. Dobra optymalizacja techniczna pod kątem wyszukiwarek i dostarczania przydatnej z perspektywy użytkowników treści również ma fundamentalne znaczenie. Ważne jest także to, aby dostosować stronę pod rzeczywiste wyszukiwania użytkowników tak, by intencja wyszukiwania pokrywała się z tym, co przedstawia nasza witryna.

Jednak nawet jeśli powyższe działania wykonamy całkowicie poprawnie, wciąż nie ma gwarancji sukcesu. Najważniejsze wnioski płynące z analiz Ahrefs nie napawają optymizmem. Zaledwie 3,45% stron otrzymuje ruch organiczny z Google. Cała reszta musi obejść się smakiem. I choć wiele z tych stron to strony spamowe, duplikaty czy po prostu zapomniany witryny sporządzone jeszcze w zwykłym html, to jednak wciąż pozostaje niedosyt. Wnioski są jeszcze mniej ciekawe, jeśli weźmiemy pod uwagę zapowiedzi związane ze zmianami w obrębie Google Ads oraz rozwojem snippetów i obszarów SGE wspieranych przez A.I.