Wysokie zapotrzebowanie na treści na strony internetowe przyczynia się do ogromnej popularności modułów językowych. Chociaż powstają nowe, ciekawe rozwiązania, np. Google Bard z modułem Gemini, wciąż pierwsze miejsce na podium zajmuje Chat GPT. Nie każdy jednak chce otrzymywać treści tworzone przez A.I. Problem zaczyna być coraz poważniejszym zarówno w branży SEO, jak i w dziennikarstwie, oświacie, a nawet szkolnictwie wyższym. W tym artykule przyglądamy się rozwiązaniom tego problemu, czyli tzw. Chat GPT Detector, które – rzekomo – mogą sprawdzić, czy tekst został napisany przez A.I.!

Treści A.I. to miecz obosieczny

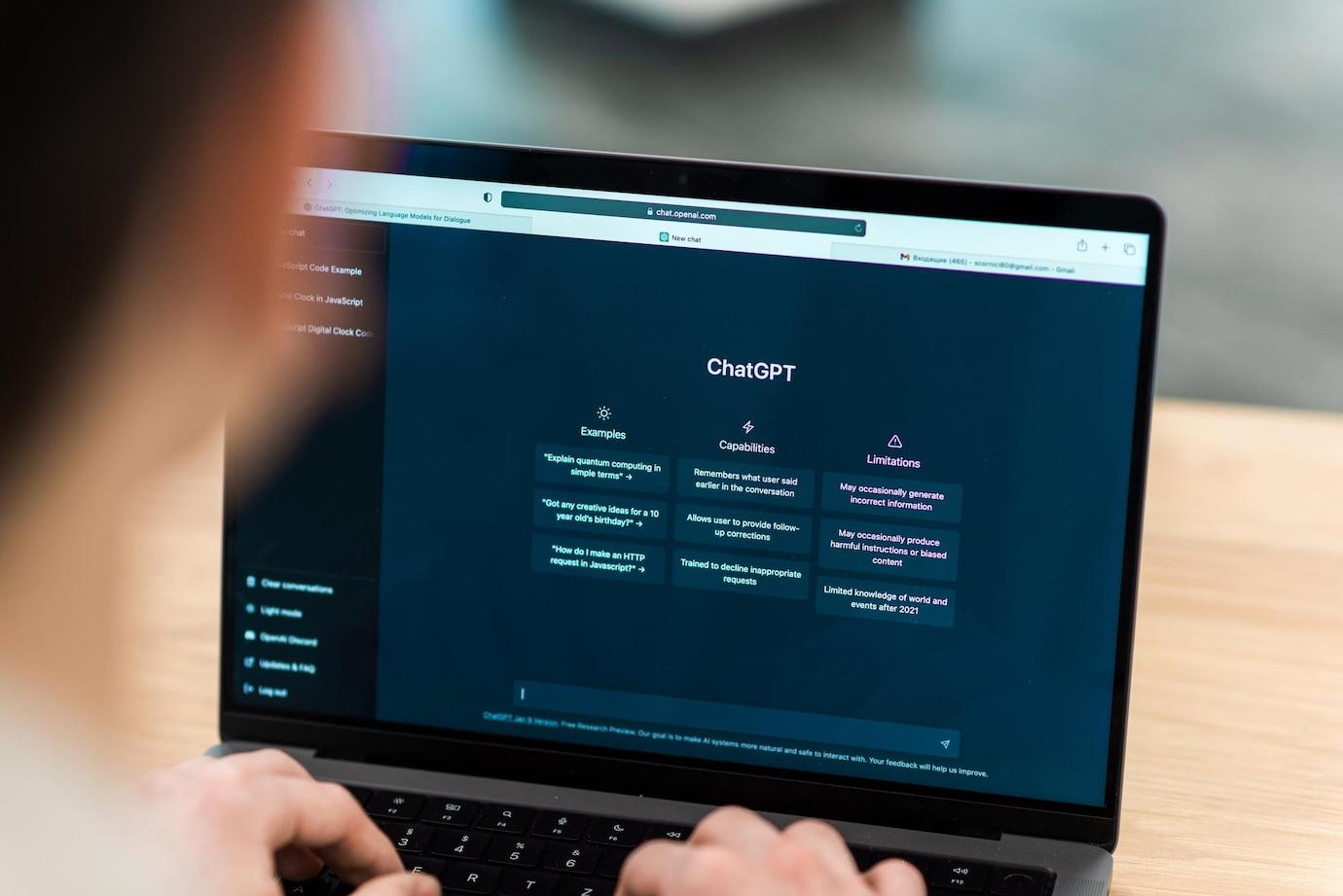

Od momentu upublicznienia pierwszego modelu językowego w tak zaawansowanym stopniu wykorzystującym uczenie maszynowe, Chat GPT od Open A.I., minął już rok. W tym czasie mieliśmy do czynienia z ogromną rewolucją technologiczną, jak społeczną, widoczną zarówno w branży IT i marketingu internetowego, jak i w pozostałych dziedzinach. Chat GPT szybko zweryfikował sytuację na rynku pracy, co skutkowało natychmiastowym ograniczeniem liczby miejsc pracy związanych głównie z dwiema dziedzinami: copywritingiem (tworzeniem treści na strony internetowe) i mniej zaawansowanym programowaniem. W tych obszarach stanowiska juniorskie zaczęły znikać z dnia na dzień.

Obecnie trudno znaleźć twórcę treści internetowych czy programistę, który nie korzystałby z Chat GPT wcale. Narzędzie to znacznie ułatwia i przyspiesza pracę. Cały proces researchu, który należy wykonać przed stworzeniem treści, może być przeprowadzony znacznie efektywniej. Problemy pojawiają się jednak, gdy chcemy uzyskać gotowy tekst.

Dla jasności trzeba uczciwie przyznać, że zarówno Chat GPT, jak i Google Bard (z Gemini) potrafią już w satysfakcjonującym stopniu dostosowywać się do komend użytkownika. Możemy określić dokładnie nie tylko, jakie słowa kluczowe ma zawierać tekst, jaką ma mieć objętość i tematykę, ale także przygotować specjalistyczny content plan. Może on uwzględniać rozkład i hierarchię nagłówków html, może określać stylistykę treści, sposób zwracania się do odbiorcy itd. Algorytmom AI można też podać własne fragmenty, które mają być użyte w tekście bądź przesłać wcześniej wręcz nieskończoną ilość treści, na której moduł ma się wzorować przy opracowywaniu nowego tekstu.

Jedyny problem polega na tym, że optymalizacja komend A.I. jest procesem trudnym, żmudnym i czasochłonnym. Okazuje się, że osoba niedoświadczona w pisaniu może mieć większą trudność w rzetelnym przygotowaniu wytycznych do tekstów dla A.I., niż doświadczony copywriter z napisaniem całego tekstu od A do Z.

Rezultatem takiego stanu rzecz jest rosnąca, przytłaczająca ilość treści niskiej jakości, która powstaje maszynowo przy wsparciu modułów A.I. Treści te charakteryzują się brakiem oryginalności, a uzasadnienie ich istnienia w takiej ilości w branży SEO wynika wyłącznie z nieudolności Google, które twierdzi, że stawia na jakość, podczas gdy algorytmy wciąż patrzą głównie na słowa kluczowe. Powyższe mankamenty widać szczególnie w drugiej połowie 2023 r., w tym również w okresie świątecznym, kiedy Google ewidentnie nie może poradzić sobie z zalewającymi topowe pozycje stronami spamerskimi.

Jak sprawdzić, czy tekst został napisany przez A.I.?

Można założyć, że prędzej czy później sytuacja się unormuje, a algorytmy będą tak dopracowane, aby lepiej identyfikować jakość treści. Tajemnicą Poliszynela jest kwestia tego, że Google równolegle do prac związanych z Bardem i Gemini, opracowuje własne narzędzia, które w założeniu miałyby identyfikować pochodzenie treści. Na rynku od miesięcy dostępne są jednak niezależne narzędzia, których celem jest sprawdzenie, czy tekst został napisany przez człowieka, czy maszynę. Mają one poprawić jakość treści na stronach również w sytuacji, kiedy nieuczciwi copywriterzy i dziennikarze webowi dostarczają rezultaty opracowane przez A.I.

Jak sprawdzić, czy tekst został napisany przez A.I.? Jeżeli tekst powstał bez szczegółowych komend użytkownika, wprawiony redaktor czy copywriter jest w stanie bez trudu rozpoznać specyficzną składnię Chata GPT. Stanowi ona w dużej mierze kalkę językową z języka angielskiego. Teksty tworzenie przez moduły językowe A.I. mają też charakterystyczną, powtarzającą się strukturę trzyczęściową. Pierwszy akapit zawsze obejmuje wprowadzenie, które prawdę mówiąc rzadko kiedy ma potencjał do faktycznego zainteresowania odbiorcy. Następnie moduł przechodzi do tego, o co de facto był proszony, wykorzystując jakieś informacje techniczne, szczegółowe, wymagające zasięgnięcia do baz, na których się opiera. Popularne błędy, wynikające z niewłaściwie przyjętych kalek językowych, dotyczą interpunkcji (np. “Dalej, (…)” jako prawdopodobnie tłumaczenie angielskiego linking word ‘what’s more’, ‘furthermore’ czy ‘in addition’). Całość tekstu wygenerowanego przez Chat GPT kończy się podsumowaniem – i to jest ta część, którą najprościej rozpoznać samodzielnie. Moduł najczęściej rozpoczyna ją od słów (w przypadku treści tworzonych w języku polskim): “Podsumowując, (…)” i “Reasumując, (…)”.

Programy do sprawdzania, czy tekst został napisany przez A.I. Przegląd najpopularniejszych

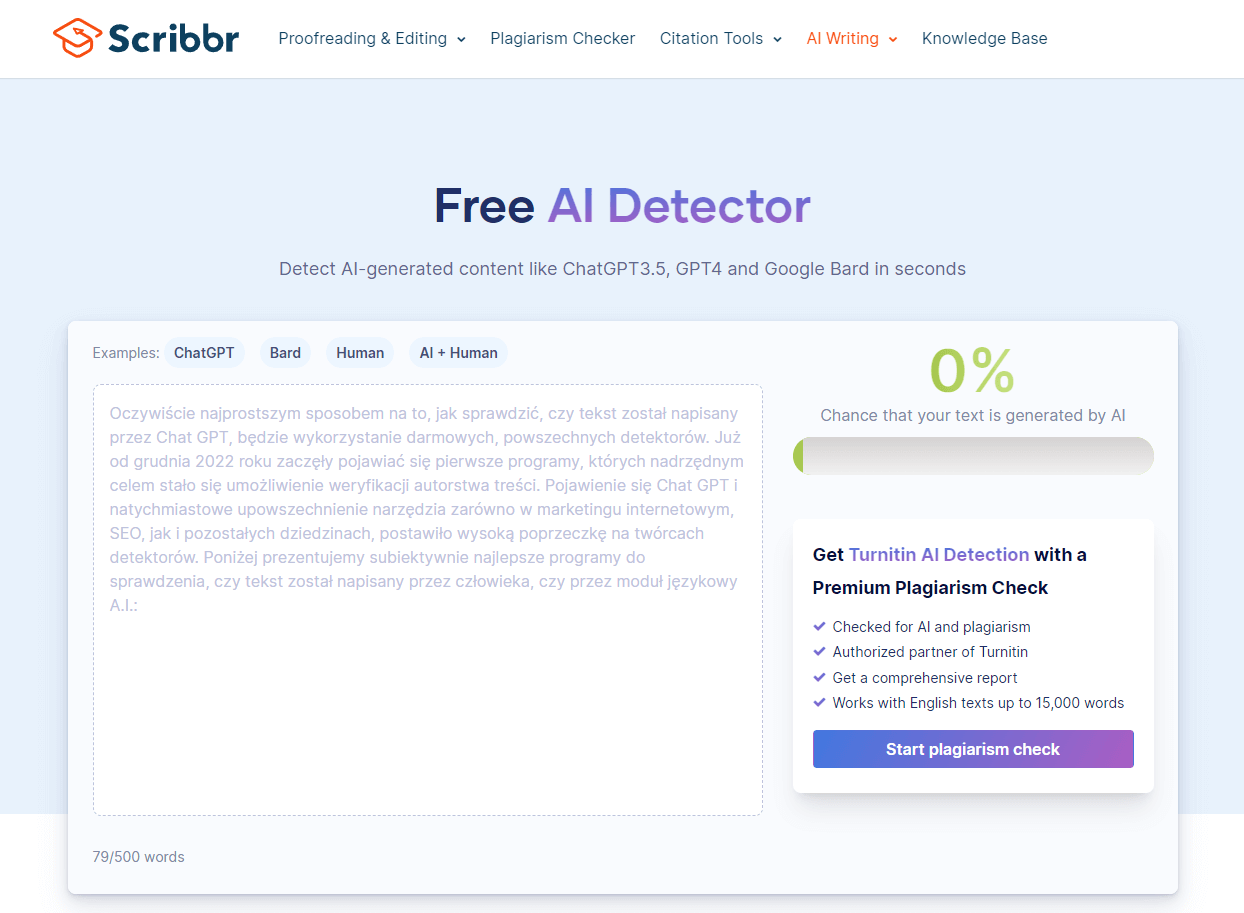

Oczywiście najprostszym sposobem na to, jak sprawdzić, czy tekst został napisany przez Chat GPT, będzie wykorzystanie darmowych, powszechnych detektorów. Już od grudnia 2022 roku zaczęły pojawiać się pierwsze programy, których nadrzędnym celem stało się umożliwienie weryfikacji autorstwa treści. Pojawienie się Chat GPT i natychmiastowe upowszechnienie narzędzia zarówno w marketingu internetowym, SEO, jak i pozostałych dziedzinach, postawiło wysoką poprzeczkę na twórcach detektorów. Poniżej prezentujemy subiektywnie najlepsze programy do sprawdzenia, czy tekst został napisany przez człowieka, czy przez moduł językowy A.I.:

- Scribbr A.I. Detector– rozwiązanie od Scribbr ma potężne zalety: jest darmowe, szybkie, nie wymaga dodatkowej aplikacji, konta czy logowania. Analizuje treść zarówno pod kątem wpływu Chat GPT, jak i Google Bard. Darmowa wersja ma średnią wykrywalność i ograniczenie objętościowe tekstu do 500 słów.

- Zero GPT – prosty, darmowy detektor treści A.I. online. W bieżących, codziennych pracach redaktorskich może być na wagę złota. Należy używać rozsądnie, bo nierzadko zdarzają się fałszywie pozytywne rekomendacje. Na uwagę zasługuje jednak dość wysoko postawiony limit objętości treści dla wersji darmowej – aż 15 000 znaków.

- GPT Zero – według danych z WebArchive GPT Zero o 18 dni wyprzedziło Zero GPT, ale nie jest jasne, czy serwisy stanowią dla siebie faktyczną, czy pozorowaną konkurencję. Faktem jest jednak to, że GPT Zero oferuje rzetelną weryfikację autorstwa treści pod kątem treści pisanych przez człowieka, modelu GPT 4.0 i Llama 2.0. Z ostrożnością należy podchodzić jednak do udostępnianych na stronie danych.

- Content at Scale – AI Content Detector od Content at Scale mocno przypomina rozwiązanie Scribbr zarówno pod kątem designu interface’u, jak i samej funkcjonalności narzędzia. Niestety, wersja darmowa jest maksymalnie ograniczona, a cena płatnej mało konkurencyjna.

- Originality AI – prawdopodobnie najbardziej profesjonalny detektor treści AI w kategorii narzędzi, które mają błyskawicznie wykonać swoje zadania. Dostępny w wersji darmowej i płatnej. Originality AI umożliwia szybką weryfikację, czy tekst został napisany przez Chat GPT, Google Bard, czy człowieka. Sprawdza też pod kątem możliwego plagiatu i błędów językowych.

- Winston AI– płatny, choć dostępny w ograniczonej wersji za darmo, zaawansowany detektor treści z integracją z Chat GPT, Google Bard i nie tylko. Wykazuje się jedną z największych skuteczności w przypadku pracy z językiem angielskim. Ma też szereg innych, ciekawych funkcji, w tym m.in. rozszerzenie API, grupowanie zadań w projekty, analiza słów kluczowych, ocena objętości i jakości treści, sprawdzenie pod kątem plagiatu. Wszystko to dostępne w intuicyjnym interfejsie webowym.

Jak działa A.I. Detector? 3 etapy procesu detekcji

Wykrywanie, czy dany tekst został napisany przez człowieka, czy opracowany model językowy, wymaga dokładnej analizy tekstu w poszukiwaniu cech charakterystycznych dla danego pochodzenia. Identyfikacja pochodzenia treści przez narzędzia detekcyjne przeprowadzana jest na kilku różnych poziomach. Pierwszy poziom to analiza słownictwa i składni. Dobre narzędzie detekcyjne powinno analizować całą strukturę zdania przy wykorzystaniu metod przetwarzania języka naturalnego (NLP). Bazy detektorów powinny być wyposażone w przykłady z różnych języków; wzorce słownictwa, składni i charakterystycznych cech dla danego języka.

Drugim poziomem analizy jest kontekst. To właśnie umiejętność rozpoznawania kontekstu najbardziej upodabnia zaawansowane detektory do znanych modeli językowych. Aby weryfikać, czy poszczególne człony struktury tekstu pasują do siebie, czy nie, prezentują charakterystyczne dla człowieka elementy, czy są “ścianą tekstu” wygenerowaną przez A.I., konieczna jest również umiejętność uczenia maszynowego. Na tym poziomie narzędzie detekcyjne powinno być zdolne do weryfikacji, czy analizowany tekst wykazuje zdolność do generowania spójnych i sensownych odpowiedzi w różnych kontekstach. Warto zwrócić uwagę, że za możliwość dostosowania kryteriów oceny treści, a także wykrywania ewolucji w zakresie generatywnych modeli językowych, również odpowiadają procesy związane z uczeniem maszynowym.

Trzecim i ostatnim etapem jest identyfikacja modeli językowych. Obecnie najpopularniejszy jest Chat GPT, a drugie miejsce pod względem liczby użytkowników wykorzystujących narzędzie zajmuje Google Bard. Detektor powinien potrafić rozpoznać, czy dany tekst bądź jego fragment powstał przy użyciu Chata GPT, czy Google Barda.

Weryfikacja autorstwa treści wymaga nowych rozwiązań? Skuteczność detektorów A.I.

Narzędzia analizujące treść mają ograniczoną skuteczność. Trudno jednoznacznie przewidzieć, jaka wytworzy się w kolejnych miesiącach tendencja, jednak na ten moment przewagę mają zdecydowanie modele językowe. Detektory wciąż są nie tyle niedoskonałe, co zbyt często popełniają błędy bądź prezentują fałszywie pozytywne alerty.

Najwięcej błędów pojawia się przy pracy z treścią napisaną w innym języku, niż angielski. W przeciągu ostatnich miesięcy opublikowane zostały badania, z których jednoznacznie wynika, że programy do detekcji tekstu błędnie klasyfikują próbki tekstów napisane przez osoby, których językiem ojczystym nie jest angielski. Jednocześnie poprawnie identyfikowane są teksty napisane przez osoby anglojęzyczne. W przypadku języków innych niż angielski skuteczność detektorów według badania wyniosła nieco ponad 50%.

Co więcej, detektory jeszcze gorzej radzą sobie w sytuacji, gdy prompt zapytania obejmuje bardziej zaawansowane komendy, np. dotyczące specyficznego stylu, jakiego ma użyć A.I. bądź wzorowania się na faktycznym tekście napisanym przez człowieka. Efektywność wykrywania tak wygenerowanego tekstu jest obecnie bardzo niska.

Dlaczego tak istotny jest rozwój narzędzi do sprawdzania autorstwa treści?

O detektorach A.I. mówi się już prawie tak głośno, jak o samym Chat GPT czy Google Bard. Nic zresztą dziwnego. Skala generowanych treści w 2023 r. pokazała, że jeżeli sytuacja prędko się nie zmieni, czeka nas rewolucja nie tylko w obszarze IT. Umiejętność skutecznego rozpoznawania, czy dana treść powstała przy użyciu A.I., czy została napisana przez człowieka, może być kluczowa w przyszłości.

Marketing internetowy i SEO

W 2023 roku mamy wysyp spamerskich stron internetowych, z którymi zdecydowanie nie radzi sobie Google. Amerykański gigant w ostatnim czasie odnosi zresztą znacznie większe sukcesy w zakresie rozwoju A.I. (Gemini), niż zapewnieniu stabilności w SERP i jakości chociażby w systemach reklamowych (Google Ads).

Zdecydowana większość treści, która powstała przez ostatni rok, to treści wygenerowane, a nie napisane. Jeżeli szukamy treści autorskich, trzeba rozglądać się po tematach specjalistycznych, niszowych, felietonach, gdzie istotny jest styl pisarza oraz materiałach dziennikarskich. Wszystko inne generowane jest przez Chat GPT / Google Bard.

Ma to bardzo niekorzystny wpływ na pozycjonowanie stron internetowych. Pomimo nastawienia na jakość contentu, rozszerzenia grafów wiedzy (E-A-T → E-E-A-T → N-E-E-A-T-T), tworzenie spamerskich stron było – obok nietrafionych aktualizacji Google’a – głównym powodem spadków pozycji w minionym roku. Wygląda na to, że algorytmy wciąż nie są w stanie dokładnie weryfikować pochodzenia treści, co przekłada się na dalszą dewaluację naprawdę merytorycznych tekstów pisanych przez pasjonatów i ekspertów.

Oświata i nauczanie

Problemy szybko zaczęły dotykać też naukę. Nauczyciele praktycznie na całym świecie zgłaszają nowy problem: generowanie treści przez A.I. Zadania domowe bez trudu rozwiązywane są przez Chat GPT czy Google Bard. Modele językowe są w stanie dostarczyć wzory matematyczne czy fizyczne, wyjaśnić, na czym polega dane zjawisko geograficzne, wypisać niezbędne daty i wydarzenia do sprawdzianu z historii, a nawet napisać całe wypracowanie. W tym bądź w innym języku. Nauczyciele nie są przygotowani na pojawienie się A.I., bo nikt ich do tego nie przygotował.

Szkolnictwo wyższe i nauka

Osoby spoza tego sektora mogą być zdziwione, jednak wpływ A.I. na szkolnictwo wyższe jest chyba jeszcze większe, niż na oświatę. Naukowcy oszukują notorycznie. Renomowane wydawnictwa naukowe skarżą się na zalew artykułów naukowych wygenerowanych w całości bądź znacznej części właśnie poprzez modele językowe A.I.

Weryfikacja tekstów napisanych przez A.I. – podsumowanie

Chat GPT i pozostałe główne modele językowe LLM wykorzystywane są już praktycznie do wszystkiego. Stwarza to ogromne ryzyko nadużyć. Na rynku istnieje wiele narzędzi, tzw. detektorów A.I., których skuteczność jest jednak ograniczona.

Jak wynika z naszej analizy, kwestia tego, jak sprawdzić, czy tekst został napisany przez człowieka, czy AI, jest znacznie bardziej skomplikowana. Ze względu na możliwość zaprogramowania modułu tak, aby wykorzystywał gotowe fragmenty bądź stylizował tekst w określony sposób, możliwość identyfikacji autorstwa treści jest bardzo ograniczona. W przypadku tekstów pisanych w językach innych, niż angielski, prawdopodobieństwo na poziomie jedynie nieco ponad 50%. W wielu przypadkach można by więc równie dobrze rzucić kostką.

Ostatecznie warto na koniec zadać sobie pytanie: co jeśli ludzie po prostu przestaną pisać samodzielnie? Taki eksperyment myślowy prowadzi do pesymistycznych wniosków. Można spodziewać się momentu, kiedy nowe modele językowe będą kształciły się na bazach szkoleniowych stworzonych z treści wygenerowanych przez poprzednie modele LLM. Już teraz widoczne jest powielanie przez moduły A.I. powszechnych błędów, które znalazły się m.in. na Wikipedii, czego można byłoby uniknąć, gdyby zamiast tego w bazie wykorzystano priorytetowo np. Encyklopedię Britannica. Czasu na refleksję jest jednak coraz mniej.

Ten tekst nie został napisany przy użyciu A.I. Nie zmienia to jednak faktu, że prawdopodobnie mógłby zostać!